您是否已经失去了对人性的信任?这句话在AI技术突飞猛进之际更是经常浮现在我们的脑海中,仿佛带着沉重的怀疑和追问。随着世界上各类悲剧与事件的不断升级,随着痛苦的真相不断被揭露,我们对人性的信任开始逐渐褪色和消失。

在巴勒斯坦加沙地带,有超过230万人面临着灭绝和饥饿的威胁。随着一些国家的政府停止支持和资助近东救济工程处(联合国巴勒斯坦难民救济和工程处),一个严酷的事实已浮出水面,那就是人性已经辜负了人类,而现在,在这个人工智能时代,是我们将希望寄托在非人类身上的时候了么?

鉴于这些悲惨事件,人工智能作为一项有争议的话题出现在了我们面前,恐惧与希望交织在一起,我们也迫切需要了解人工智能的本质及其工作原理。只有通过这种认识,我们才能知道人工智能是否能在某一天主动引领人类走向光明的未来,或者它是否会成为加速人类灭亡的机制。

技术还是人类?将人工智能融入军事行动,这在最近的冲突中发挥了关键作用,并导致平民伤亡人数大幅上升。

人工智能的军事化对全球安全产生了严重的影响,包括开发和部署无需人工干预即可自动运行的致命武器系统,从而增强了技术先进国家对第三世界国家的军事主导地位。

人工智能使破坏性的常规武器变得更加智能,人工智能被用于但不限于分析无人机镜头和其他情报来源,以识别目标、制导导弹和先进的间谍系统。

这就是以色列在加沙战争中选择和扩大目标的方法。以色列使用了一种名为“哈布苏拉”的人工智能系统以加快其袭击目标的速度——该系统致力于从各种来源提取大量信息(例如通信数据、飞机镜头和监视数据),然后进行分析并生成袭击目标建议。

这种转变引发了关于技术进步对人性本质及其对生命的尊重程度的影响的深刻问题。在战争中使用人工智能是一个复杂的问题,需要我们仔细研究其在人道主义、法律、伦理和安全层面所存在的影响。

这就又回到了关于破坏性技术对我们人性影响的问题:究竟是它扭曲了我们的人性?还是说,它只是反映我们与生俱来的扭曲人性的一面镜子?

哈佛大学伯克曼克莱因互联网与社会中心副教授保拉·里库尔蒂认为,占据主导地位的人工智能已经成为一股能够通过三个认知过程实施暴力的力量:通过提取和征用进行的数据转换过程,通过调解和优化进行的算法化过程,以及通过暴力、不平等、转移责任实现的自动化过程。

保拉发现,这些复杂的认知机制导致了全球分类系统的发展,从而加剧了世界不同民族之间的认知、经济、社会、文化和环境的不平等。

尽管这些问题对人类使用人工智能提出了挑战,但另一方面,在计算机科学家和发明家雷·库兹韦尔看来,人类生活的各个方面似乎都有着进步和改善的机会。值得一提的是,库兹韦尔因其在人工智能领域内的工作及其对技术未来的预测而出名。

作为人工智能未来的乐观主义者之一,库兹韦尔相信这项技术将成为应对威胁人类的重大全球挑战的关键。库兹韦尔还相信,与这种人工智能的融合将会打开无限的可能性之门,并让我们能够极大地克服阻碍我们增强能力的生物学限制。

库兹韦尔相信,通过人工智能的不断改进,人类将能够利用此类技术提供的卓越心智能力而取得前所未有的成就。

毫无疑问,库兹韦尔的预测为人类获得拯救的未来带来了希望,但是人类能力的增加却不可避免地伴随着损害和破坏力的增加。但是道德价值观仍然是避免破坏性冲突的最有效威慑,因此,我们必须认识到什么是道德价值观。

存在有意识的机器吗?在过去几年内,人工智能在发展工业、处理自然语言、诊断疾病、生产治疗方法、制造机器人等许多领域取得了长足的发展,但是这些发展仍然停留在人工智能的狭隘版图之内,而意识的概念仍然是一个复杂而引人重视的话题。

哲学家约翰·希尔勒为其提出的“中文房间”思想实验奠定了基础,以挑战这样一种说法:一些能够通过某些命令而运行程序的机器,只要有足够的算力就能拥有类似于人类的“思想”或者“意识”。该实验是为了反驳那些支持可能存在强大且有意识的人工智能的观点。

在“中文房间”的实验中,假设在一个封闭的房间内存在一位不懂中文的人,但是通过遵循这个语言的各种书面规则,这个人可以使用中文给出回答,这样一来,房间外面的人就会相信房间里面的人听得懂中文。

正如房间里的人即使能够使用中文回答问题但其实也“不懂中文”一样,使用中文智能对话程序的计算机也无法理解这些对话的意义,而只是根据规则和程序来推断答案,计算机未被赋予理解中文的能力或者理性、意识。

在缺乏意识的情况下,当前的人工智能还缺乏去主动领导人类或是消灭人类的能力,而使人类变得更美好的任务也是非常艰巨的。

人工智能科学家伊恩也认同这一趋势——他认为人工智能甚至不如宠物动物那样聪明,而且当前的系统还远未达到使它们获得某些意识以变得更加聪明的程度。

机器不知道什么是暴力,也没有理由实施暴力,但人类却利用它来服务于自身的不良利益,而机器本身可能并没有意识到它正在对其他人实施暴力。如果我们害怕人工智能与人类开战,那么,难道我们不应该反过来通过更多手段来制止这种暴力的风险吗?

但即使今天的人工智能能够获得某种意识,但是要超越和控制人类,它还必须具备更加重要的东西,那就是动机。

机器的动机动机在英语中用“motivation”一词表达,而该词源于拉丁词语“mover”,意思是为行动或运动做准备。这是一个生理过程,为有机系统做好心理准备并满足需要、欲望及动机。它是有机体行为的驱动力,使其朝着目标前进并积极采取行动。根据动机的强度,它可能会让他继续该活动、停止该活动或提高其有效性。

理查德·内德·勒鲍在其著作《国家为什么要打仗?过去和未来的战争动机》中指出了国家之间发动战争的四个基本动机。这些动机包括对另一种威胁的恐惧,或者是经济、政治和战略利益,或者是渴望维持和提高自身的地位,或者是报复不公正的行为。这些动机是塑造当今国际政治动态的重要因素。

人工智能可以会对塑造政治环境产生影响,并最终可能导致人类的冲突或战争,但它本身没有任何动机——目前它仅仅被认为是一种依赖编程和数据来执行任务和做出决策的技术工具。

尽管可以在军事环境中开发能够过滤决策的先进人工智能系统,但是目前最终决策仍然取决于人类的意志。

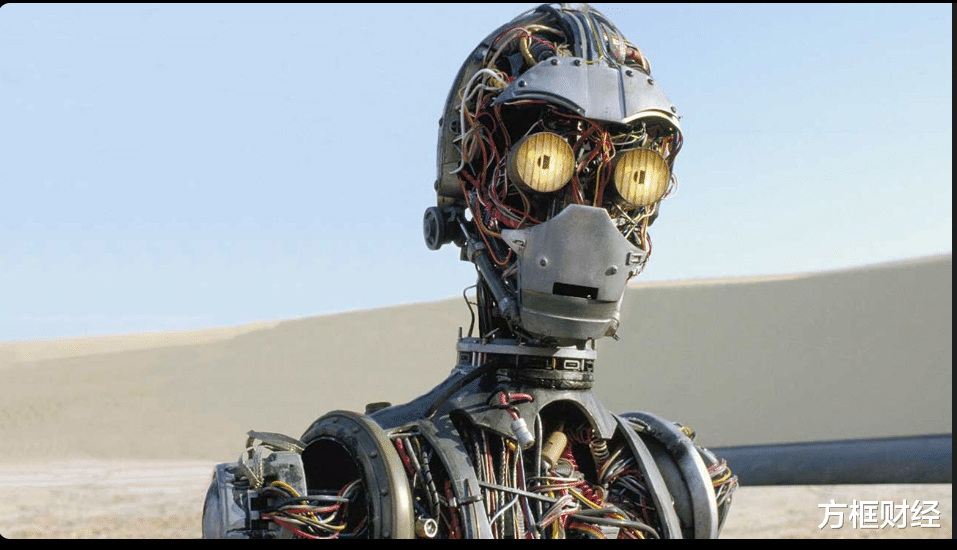

机器人性化在对技术的不懈追求中,科学家们试图让机器人变得更像人类,并寻找在这些机器中体现人类有机运动和行为的方法。尽管他们取得了巨大进步,但他们在尝试使机器人更加人性化时,仍然面临着巨大的挑战。

长期以来科学家努力将人类特征融入到机器的外表中,目的是让其外表更接近于人类,即使是那些对其功能无益的细节,例如睫毛的颤动,模仿人类的表情。 但是,尽管付出了大量的努力,机器人在模仿这些动作方面仍然缺乏准确性和流畅性。

作家和哲学家们不遗余力地尝试在自己的著作中将人类的情感植入到机器人身上,并让它们拥有跳动的心脏、有趣的个性。虽然这些尝试未能将爱、愤怒与复仇的火花带入这些机器的内部,但是它们仍在人类的想象中为这些机器创造了一种奇怪的分类,并将其分为善的机器和恶的机器。

科技的发展已经取得了长足的进步,但至今机器人却甚至无法像人类一样抬起眼睛思考自身的存在,更远远无法产生那些使人类产生情感的神秘的化学反应。

阿西莫夫定律作为小说哲学的问题,媒体写下了美国小说家、最著名的科学评论家之一艾萨克·阿西莫夫的故事——他将人工智能的伦理原则概括为三大基本定律:

第一:不允许机器人伤害人类或允许人类受到伤害。

第二:机器人必须服从人类给它的命令,除非这些命令与第一定律相冲突。

第三:机器人必须保护其存在,只要这种保护不与第一或第二定律相冲突。

尽管阿西莫夫的机器人定律是嵌入在其小说中的指令,而非科学定律,但是它在有关技术的讨论中非常重要,并且已经被许多人工智能领域内的杰出科学家讨论过,包括iRobots创始人雷·库兹韦尔,以及罗德尼·布鲁克斯、机器人科学家丹尼尔·威尔逊。

今天,我们已经开始见证并感受到人工智能所存在的实际危害,尤其是在军事行动领域。随着这些挑战的增加,我们有必要采取更为严格的法律和道德框架来控制对人工智能的使用,并确保其使用方式确保正义并尊重所有个人的基本权利。

毫无疑问,机器正变得越来越像我们——这不仅在是其外观上,而且还是在其思维方式上。也许危险就存在于这里,因为我们很难将它与我们、我们的思想和欲望区分开来。

也许人类对机器的恐惧并不在于它们明显想要伤害人类,而是因为我们试图让它们变得更像我们。如果这表明了什么事实的话,那就是人类更害怕那些与他们相似的人造实体,并且由于其复杂性,这些实体可能带领人类走上一条不可预测的道路——要么走向永生,要么走向毁灭。