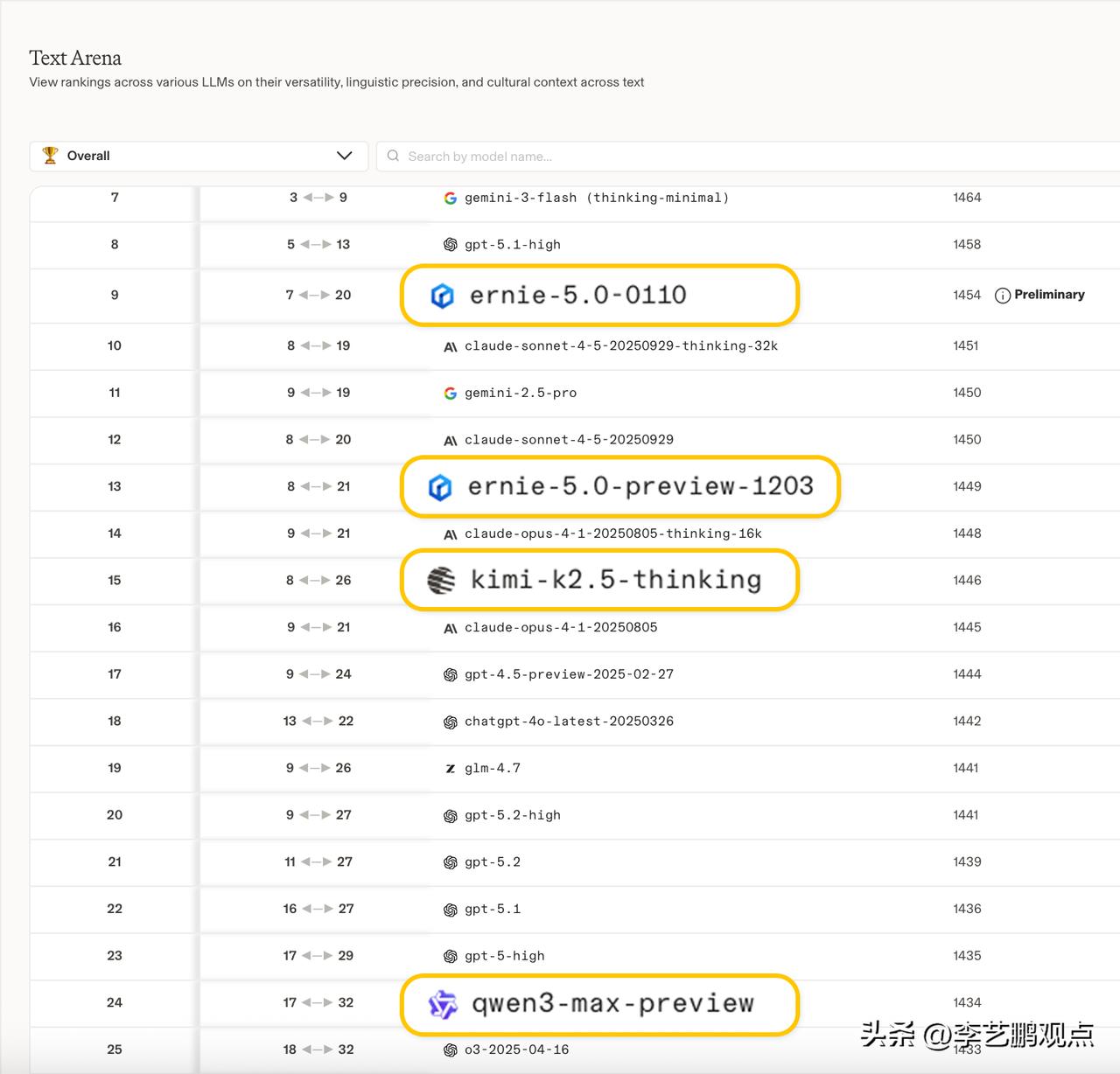

【AI三国杀暗流涌动:为什么说百度正在下一盘大棋?】 最近国产AI圈真是热闹非凡,各家大厂你方唱罢我登场——阿里刚发布Qwen3-Max-Thinking,深度求索就开源DeepSeek-OCR-2,这场技术赛跑看得人眼花缭乱。但不知道你有没有发现一个有趣的现象——讨论声量最大的,往往不是实力最强的。 大家现在聊得最多的是千问、DeepSeek等,这两个的热搜是一个接一个。可当静下心来,把各家的技术底子一项项摊开对比时,才会发现有个选手被严重低估了:百度文心。1月22日,百度发布了文心大模型5.0。没有铺天盖地的营销,没有炸场的演示视频,但懂行的人都知道这份量有多重。因为它是国内少数敢亮出“原生全模态”这张底牌的玩家。简单说,就是让AI能像人一样,同时理解文字、图片、声音、视频——这不只是技术炫技,更是未来AI交互的基础架构。而且在在权威评测LMArena上,文心5.0同时拿下了文本榜和视觉榜的国内第一。 如果说基础模型决定了一个AI的“上限”,那么OCR能力则决定了它的“下限”——也就是在实际场景中到底能不能用。前几天DeepSeek-OCR-2刚发布,百度紧跟着就开源了PaddleOCR-VL1.5。这不是简单的跟风,而是一次精准的技术对标。 现在国产AI的竞争格局,越来越像一场精彩的“三国杀”:千问(阿里)走的是推理+Agent路线,强在逻辑思维和任务拆解;DeepSeek更偏向技术创新和架构探索,敢于尝试新路径;文心(百度)同时在推进两件最有长期价值的事——把基础能力做扎实,把落地应用做透彻。 热闹是千问和DeepSeek的,但手里底牌最多的,很可能是文心。想想它手里有什么:全模态的底层架构、OCR这样的垂直领域硬实力、搜索引擎积累的海量真实数据、以及多年AI研发的工程化经验。这些都不是一朝一夕能追赶上的。 说到全模态,这可能是目前最被低估的技术方向。我们人类认知世界,本来就是多感官并用的——看到画面、听到声音、理解文字,综合起来形成认知。AI要想真正融入我们的生活,单模态能力再强也是不够的。文心5.0坚持做原生全模态,实际上是在为下一代AI交互铺设基础设施。这条路很难,需要巨大的投入和耐心,但一旦走通,护城河会深不可测。 AI行业正在经历一个关键转折,而在这个过程中,那些扎实积累、专注长期价值的选手,往往能笑到最后。文心选择的这条道路——全模态+工程落地,确实不如某些技术点那么“炫酷”,但它构建的是AI真正实用化的基础。当潮水退去,我们会发现:真正留在牌桌上的,不一定是声音最大的,但一定是底盘最稳、底牌最多的。