DeepSeek创始人梁文峰再次语出惊人!他说:“我们经常说中国AI和美国有一两年差距,但真实的差距是原创和模仿之差。如果这个不改变,中国永远只能是追随者,所以有些探索也是逃不掉的。” (阅读前请点个赞,点个关注,主页有更多你喜欢看的内容) 远瞻慧库今年的报告显示,咱中国的AI论文76.9万篇,快是美国36.8万篇的两倍了,看着挺唬人,可论文影响力只排在全球第17位,综合影响力值才0.3163,人家美国的论文平均被引用次数、发表期刊影响因子都甩咱几条街。 这就像学生考试,咱题刷得多,但难题、压轴题全靠抄答案,简单题做得再快,分数也上不去顶尖。 从专利这个角度看更明显,中国52.96万项专利全球第一,美国46.57万项排第二,可咱的专利35%集中在识别方法、28%在语音识别这种应用层技术,腾讯那12380项AI专利,大多用在微信刷脸支付这些场景,看着落地快,可底层的“根”却不在咱这。 反观美国,23%的专利都砸在处理器架构上,19%在机器学习算法,全是能卡别人脖子的硬技术,这就是模仿和原创的天壤之别。 别以为应用层做得好就能当“领跑者”,没底层原创早晚要栽跟头。 前几年咱们不少AI企业号称“比肩GPT”,结果美国一限制芯片和底层算法授权,好多大模型立马“哑火”,要么训练到一半断了算力,要么优化到关键节点就缺核心模块。 去年有家头部企业推出的对话模型,看着应答都很流畅,可一查专利,核心的Transformer架构衍生品占了80%,人家OpenAI稍微改点底层逻辑,咱这边就只能跟着走,这哪是竞争,分明成了“陪练”。 再看看梁文峰的DeepSeek,他们今年10月刚推的“盘古”多模态架构,总算在动态知识蒸馏技术上有了原创突破,能把模型更新周期压到72小时。 可这只是在别人搭好的房子里改了间卧室,离自己盖楼还差得远,都说美国的原创实力硬,因为人家是从地基开始自己造的。 OpenAI的GPT-4o,之所以能实现多模态实时交互,核心就是他们原创的“神经符号推理引擎”,这东西能让AI像人一样做逻辑判断,不是靠海量数据堆出来的。 DeepMind更狠,直接让AlphaFold破解了蛋白质折叠难题,最新的AlphaFold 4能预测复杂疾病的分子机制,这是从0到1的突破,而咱这边还在琢磨,怎么用人家的模型做药物筛选。 最关键的是,美国的原创是“体系化”的,从斯坦福、MIT的基础研究,到硅谷企业的技术转化,再到资本的长期投入,形成了闭环。 而咱的论文爆发,是因为科研评价重数量,专利多是因为企业求短期回报,基础研究这种周期长,回报晚的“冷板凳”没几个人愿意坐。 不过好在最近这半年,总算有人开始啃硬骨头了。 10月13日搜狐网报道,北京大学朱毅鑫团队研发的“小样本概念学习系统”,第一次让AI不用海量数据就能靠逻辑推理完成任务,抽象推理能力甚至超过人类顶尖选手,这才是真正的——不是跟着别人的数据跑,而是让AI长出“脑子”。 长春光机所更实在,搞出25Gb/s垂直腔面发射激光器芯片,良率99.3%,直接量产百万级替代进口,给咱的算力底座续上了命。 科大讯飞的“飞星一号”算力底座,用异构架构把训练效率提了40%,星火模型X1在数学题上超过GPT-4o,这说明只要肯扎进去研究,咱不是搞不出原创。 可这些突破还是太少太散,目前还没能形成气候。 美国AI企业每年把20%以上的营收投到基础研究,咱这边头部企业的研发投入大多砸在应用落地,能给基础算法的钱不到5%。 更要命的是人才,全球顶尖AI学者里,美国收走了62%,咱这边不少青年才俊,还在跟着国外团队做研究,自己牵头的原创项目少之又少。 梁文峰说“有些探索逃不掉”,指的就是这个,我们不能再抱着“先模仿后超越”的老黄历了,得硬着头皮啃底层算法、处理器架构这些硬骨头,哪怕十年八年没回报也得干,不然永远要看别人脸色。 那些还在吹“应用领先就是整体领先”的人,该醒醒了。 最近美国商务部又更新了AI技术管制清单,把机器学习算法的核心参数都列为禁运项,这就是在警告我们——没有原创,应用做得再花里胡哨,一制裁只能全歇菜。 现在北大的小样本学习、DeepSeek的动态蒸馏都在推进,这些原创探索虽然慢,但每一步都踩在实地上,等咱的底层技术能跟美国掰手腕了,再谈“超越”才不是空话。 中美AI的差距,从来不是一两年的时间差,是“从零到一”和“从一到十”的路径差,模仿能让咱快速跟上队伍,但原创才能让咱领到队伍前面去。 现在咱已经有了DeepSeek这样的探路者,只要把基础研究的根扎深,把原创的火种护好,总有一天能从“追随者”变成“领跑者”,要是还抱着模仿的舒服区不放,那才真的永远没机会。 对此你还有什么想说的?欢迎在评论区留言讨论!

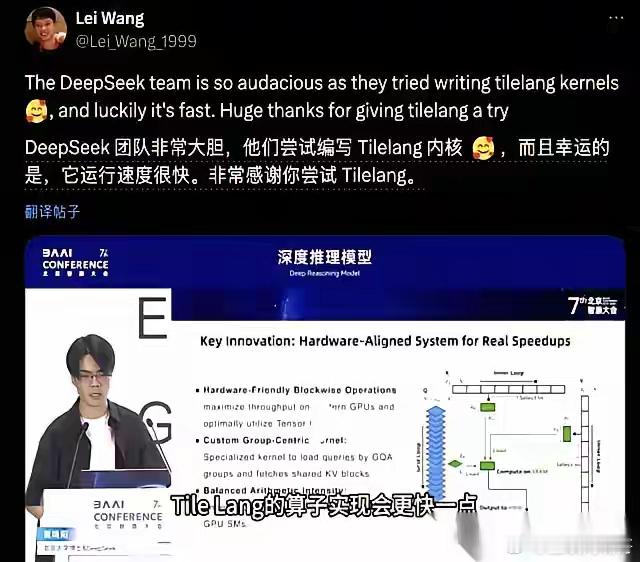

![最火ai排名,你平常用哪个[思考]](http://image.uczzd.cn/13567813052405002715.jpg?id=0)