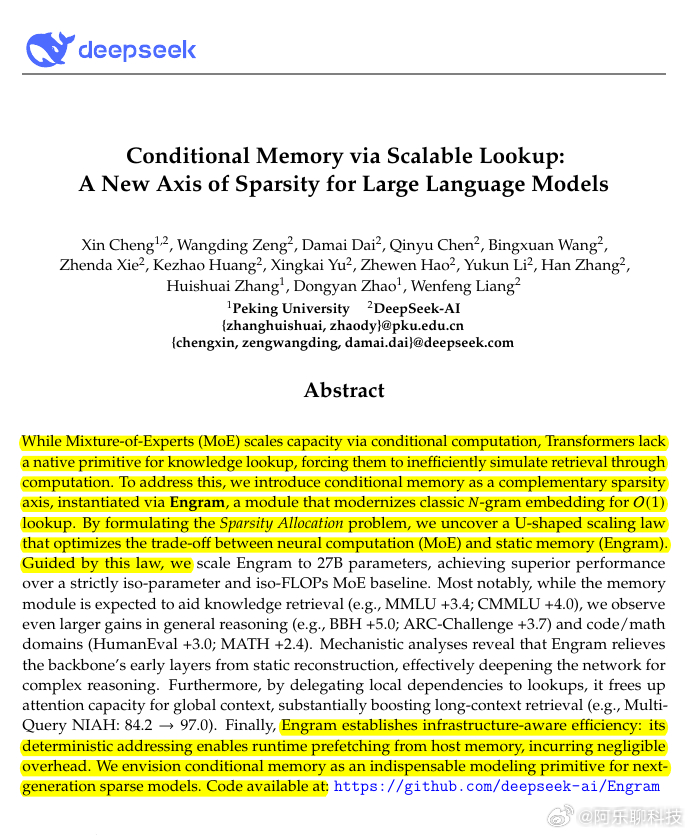

DeepSeek的创新水平确实高出一筹。它最新发表的论文揭示了一种新的 U 形标度律。这表明N元语法仍然很重要。他们并没有放弃N元语法而转向神经网络,而是将两者结合起来。这解决了维度问题,并消除了现代语言学习模型中一个主要的效率低下根源。揭示了 U 形缩放规律,优化了神经计算(MoE)和静态记忆(Engram)之间的权衡。目前,即使是“智能”LLM 也会浪费大量早期层从头开始重建常用短语和名称,因为它们没有简单的内置“查找表”功能。混合专家模型已经通过每个标记只运行几个专家块来节省计算资源,但它仍然迫使模型花费计算资源来回忆静态内容,例如命名实体和公式风格的文本。Engram 本质上是一个巨大的记忆表,它使用最后几个标记进行查询,因此当模型看到熟悉的短模式时,它可以快速获取存储的向量,而无需通过许多层重建它。他们使用哈希 2-gram 和 3-gram 模式来实现该查询,这意味着即使表很大,模型也始终对每个标记执行相同的少量查找工作。最大的好处是,如果早期层停止在“静态重建”上浪费时间,网络的其余部分就有了更多深度来进行真正的推理,这就是为什么即使这听起来“只是记忆”,推理分数也会上升。长上下文优势也十分显著,因为将本地短语粘合剂卸载到内存中,可以释放注意力,专注于遥远的关系,多查询大海捞针的匹配比较结果从 84.2 提高到 97.0。系统层面的关键在于成本和可扩展性,因为它们表明,可以将 1000 亿的内存表卸载到 CPU 内存,吞吐量下降幅度保持在 3% 以下,因此可以添加更多“存储的内容”,而无需将其全部放在 GPU 内存中ai生活指南ai创造营科技先锋官