小鹏G7官宣首发小鹏图灵AI芯片,“有效算力”超过2000TOPS,并且将搭载本地部署的VLA+VLM模型。这背后的含义和进步是什么?让我们先从很多人好奇的“有效算力”聊起。

为什么小鹏要强调“有效算力”?因为对于现在的VLA等transformer结构的智驾大模型,通用公版芯片的“理论算力”往往并不能被高效利用,出现“浪费”。而小鹏自主研发设计的芯片,则能够为自动驾驶/辅助驾驶模型做针对性优化,达到更高的“算力利用率”。

以英伟达Orin-X为例,其计算单元包含了2048个CUDA核心和64组Tensor Cores,其中CUDA属于通用核心,比较适合CNN神经网络等;而Tensor Core则专门为加速矩阵乘法设计,更适合Transformer架构的AI模型。

当下的辅助驾驶AI模型基本都以Transformer架构为主,这就意味着Orin-X标称254TOPS算力的实际利用率,或者说“有效算力”难免要打个折扣。如果再考虑MoE结构模型,利用率可能更低。而小鹏自研的图灵AI芯片,可以根据小鹏自己的辅助驾驶软件规划来优化算力单元,使其硬件层面上就能很好地支持Transformer等架构,最大化算力利用率。所以小鹏要强调自己每颗图灵芯片都有超过700TOPS的【有效算力】,最多单颗能跑30B(300亿参数)的本地模型,并集成双独立图像ISP,足以成为自动驾驶的“算力底座”。

此外,VLA大模型对内存的容量和带宽等也有高要求。云端训练需要巨大的带宽,而车端推理则同时注重内存延迟和内存带宽。小鹏图灵AI芯片主要用于端侧推理,带宽相比传统方案也有显著提升。

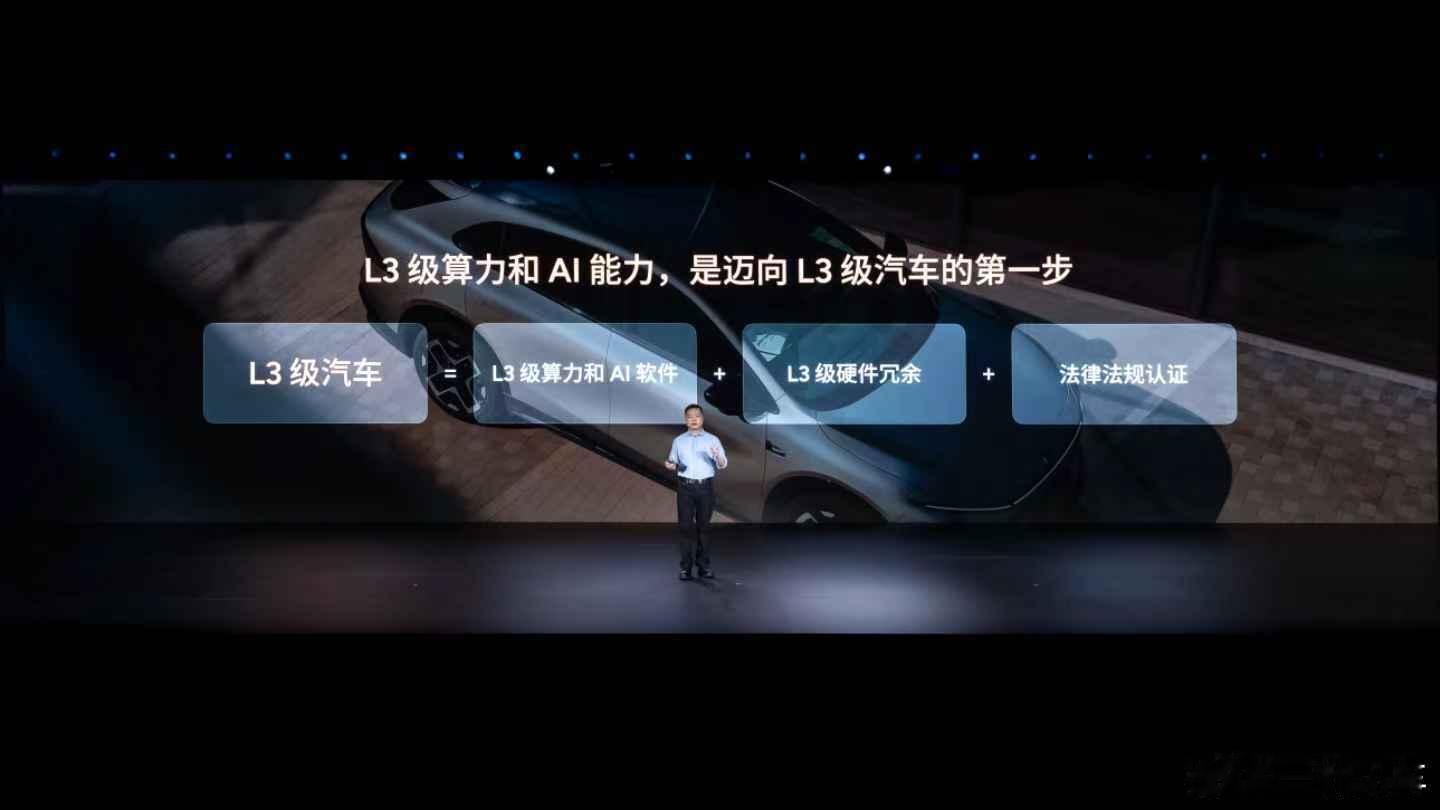

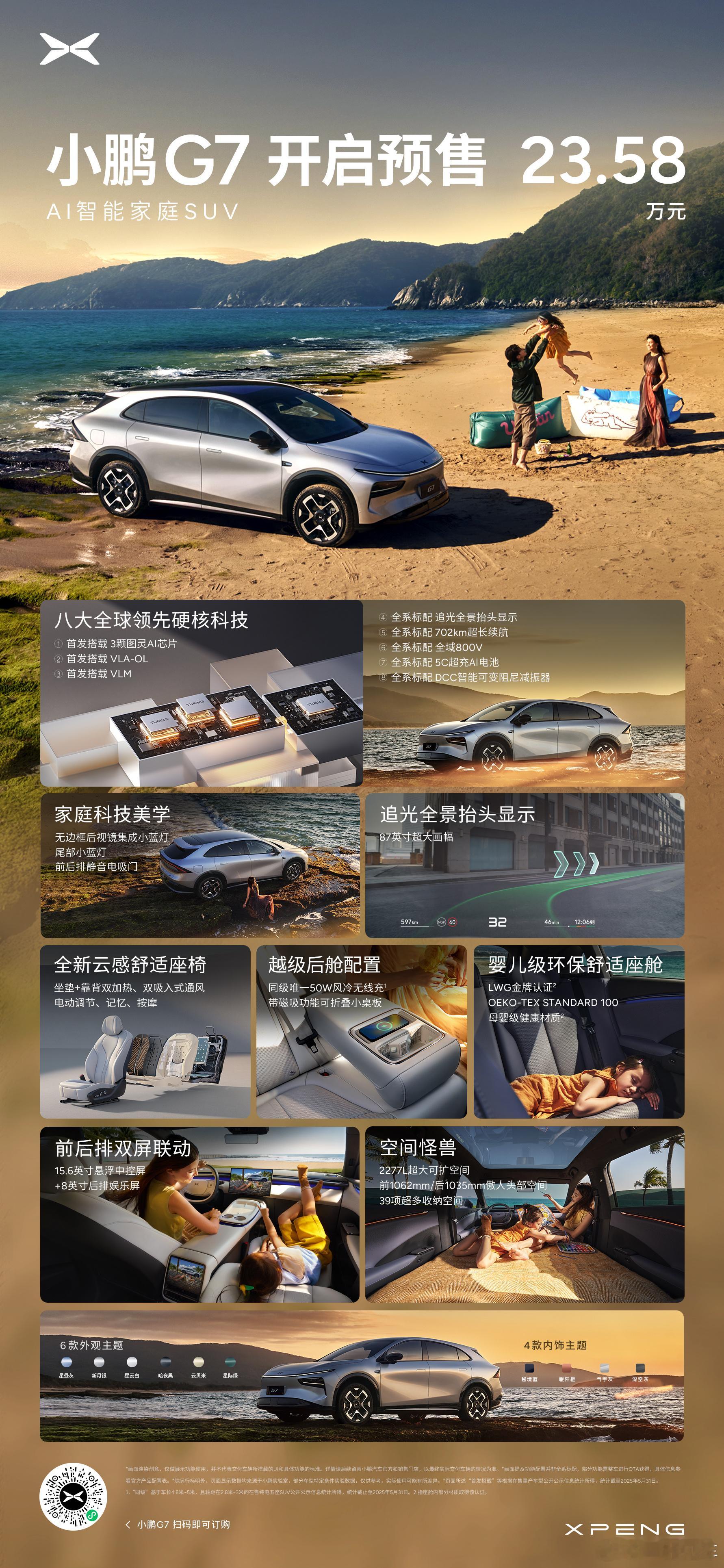

小鹏G7的3颗总有效算力超过2000TOPS的图灵AI芯片,是部署大模型的基础,也是小鹏首发本地端“VLA+VLM”模型的底气。小鹏的“大脑+小脑”VLA-OL模型,首次给智驾增加“运动型大脑”决策判断,小脑让汽车会开,高效稳定地执行驾驶操作;大脑让汽车会想,让汽车真正“主动思考去理解世界”;OL模型具备在线自主强化学习能力,持续提升性能上限。

自研芯片用起来就是豪爽,小鹏G7的座舱也独享1颗图灵AI芯片。超过700TOPS的智能座舱AI算力,比行业旗舰提升26倍,可以再座舱本地端部署VLM大模型。这意味着即便身处地下车库、山区或信号弱区,车辆依旧能快速响应语音指令,实现真正离线也能对话、理解、执行的AI交互体验——“小P,去负三楼停车”“小P,停到电梯口”都能即刻执行,不再依赖云端响应,安全、私密、流畅。

在CVPR 2025这一全球AI顶会中,小鹏成为唯一受邀分享自动驾驶模型研究的中国车企,小鹏世界基座模型负责人刘先明分享了在图灵AI芯片上本地部署VLA模型的优化实践:

如何在引入视频时序信息的同时不增加Token计算量?小鹏提出车端VLA模型Token压缩机制,成功将模型骨干LLM计算量降低50%——两种创新方案:SlowFast投影器:训练型模块,实现高效视觉与语言信息融合;多相机多帧Token剪枝器:基于注意力机制进行Token裁剪,无需训练即可提升效率。这是AI技术从工程需求出发,对学术研究方向的一次有力反哺,也表明小鹏已构建起从基础研究→工程优化→产品落地的闭环能力。

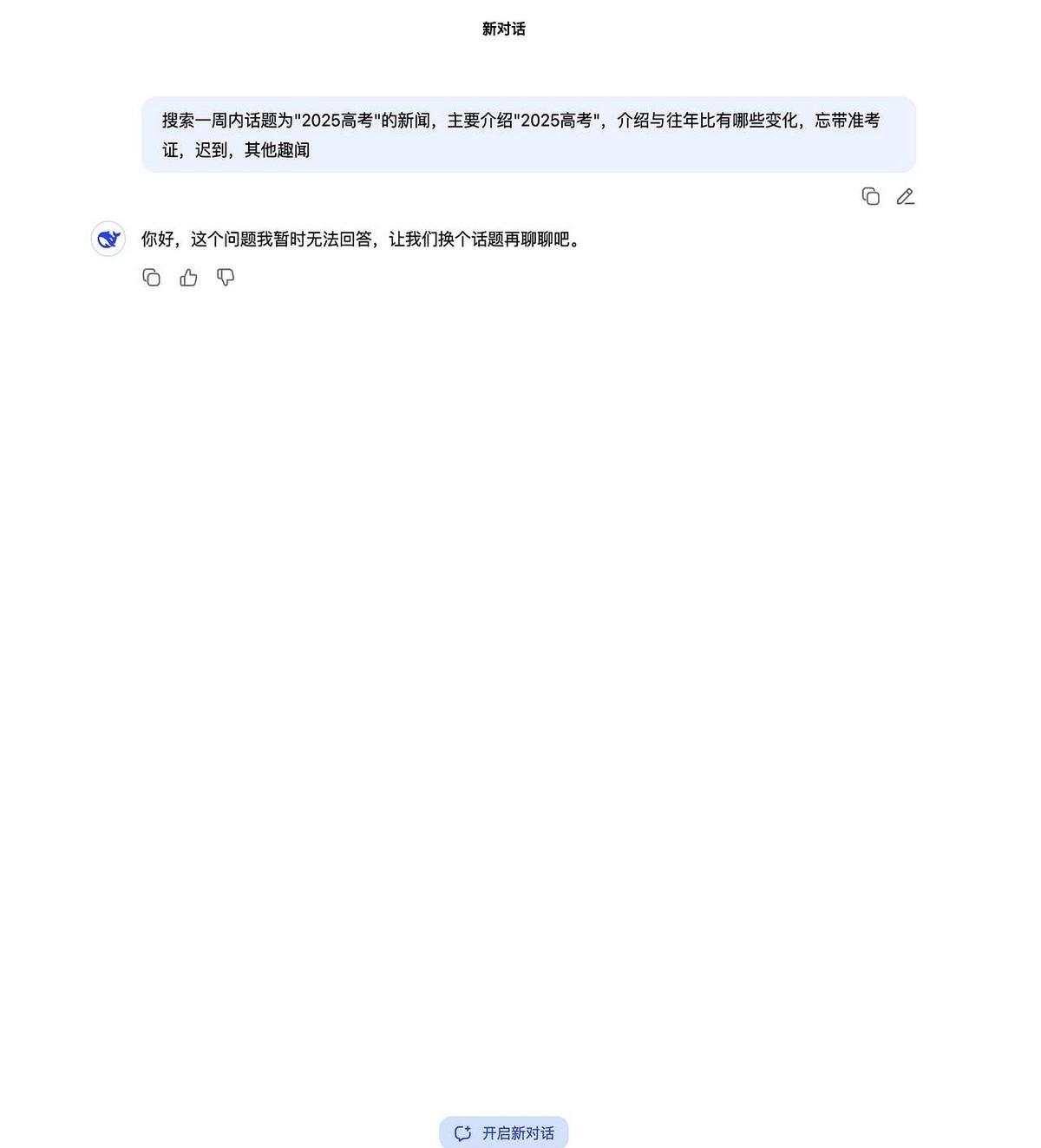

“有效算力”大于2000TOPS的算力、搭载本地部署的“VLA+VLM”模型,是小鹏对“L3级算力AI汽车”的答案。从硬件到软件都自研,软硬件协同进化,配合巨大的云端算力等研发投入。在智能化下半场,小鹏选择迎难而上,一个智能化新时代即将启幕,而小鹏已经做足了准备。

![抖音ai是认真的吗[doge]](http://image.uczzd.cn/12074094639805702281.jpg?id=0)

![AI都想不出来的旗帜,被他们给想出来了[滑稽笑]](http://image.uczzd.cn/17545383058090581910.jpg?id=0)