[LG]《Fisher-Orthogonal Projection Methods for Natural Gradient Descent with Large Batches》Y Lu, W Armour [University of Oxford] (2025)

Fisher-正交投影(FOP)优化器为超大批量自然梯度下降带来稳定且高效的训练方案。

• 解决大批量训练中一阶优化器因梯度噪声减弱导致陷入尖锐或次优极小值的问题,恢复二阶方法(如KFAC)在大批量下的优势,突破强阻尼带来的曲率信息丢失瓶颈。

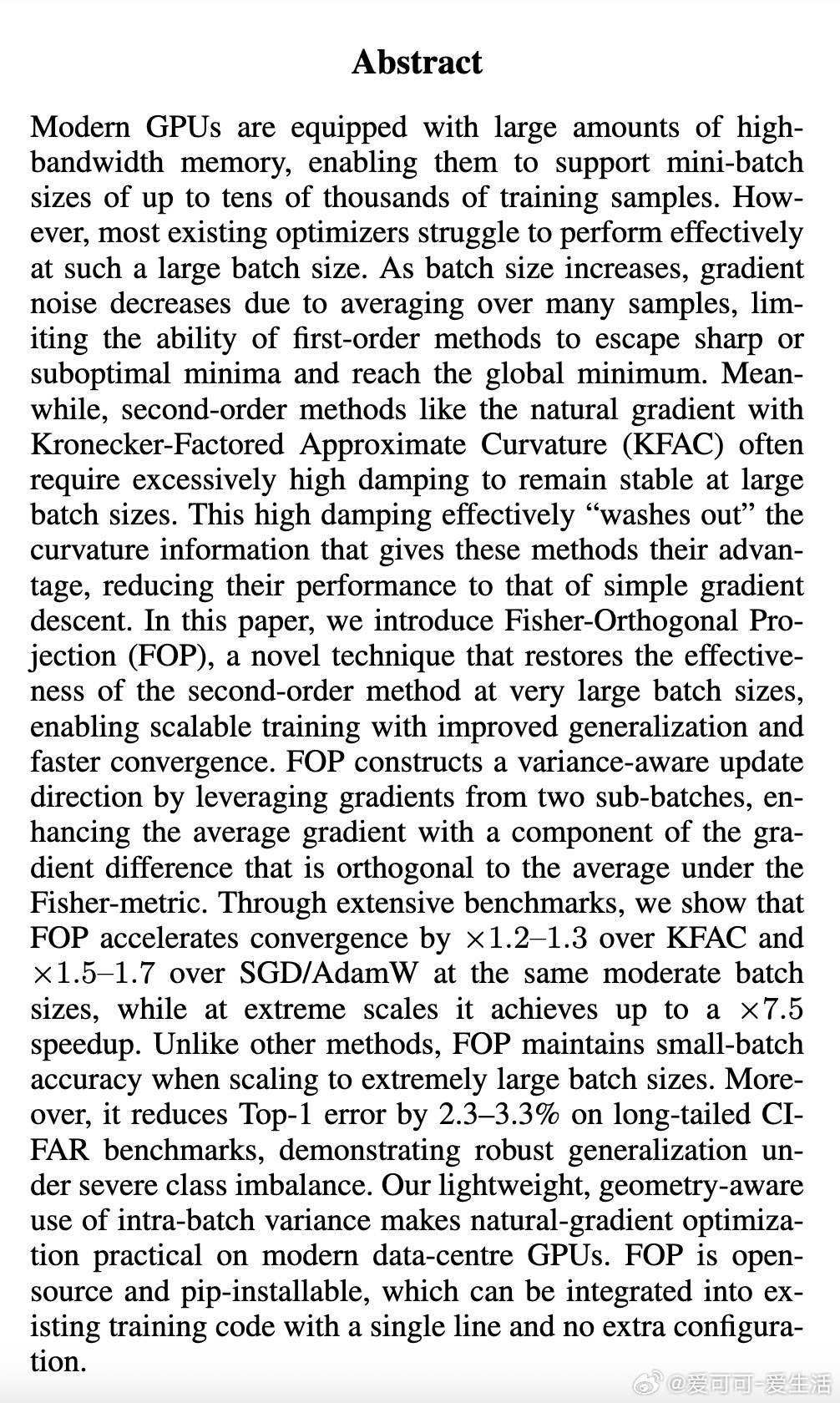

• 利用两个子批次梯度,构造Fisher度量下正交的梯度差异分量,将均值梯度与正交矫正结合,捕获迷你批内方差信息,实现几何感知的更新方向。

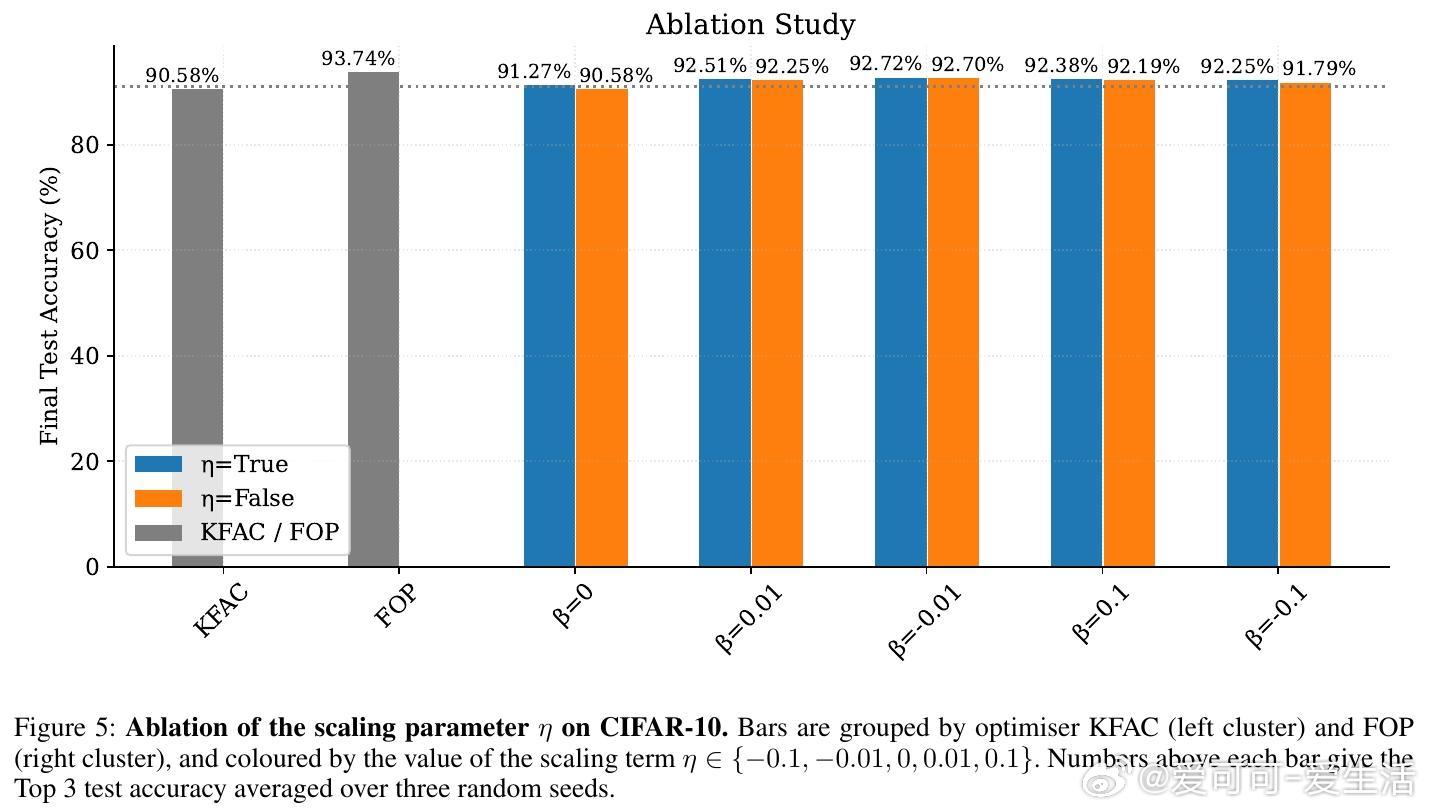

• 自适应层级系数β*和分层步长η*,基于二阶泰勒展开计算,动态平衡均值与正交分量,自动调整步幅,避免过冲并提升收敛速度。

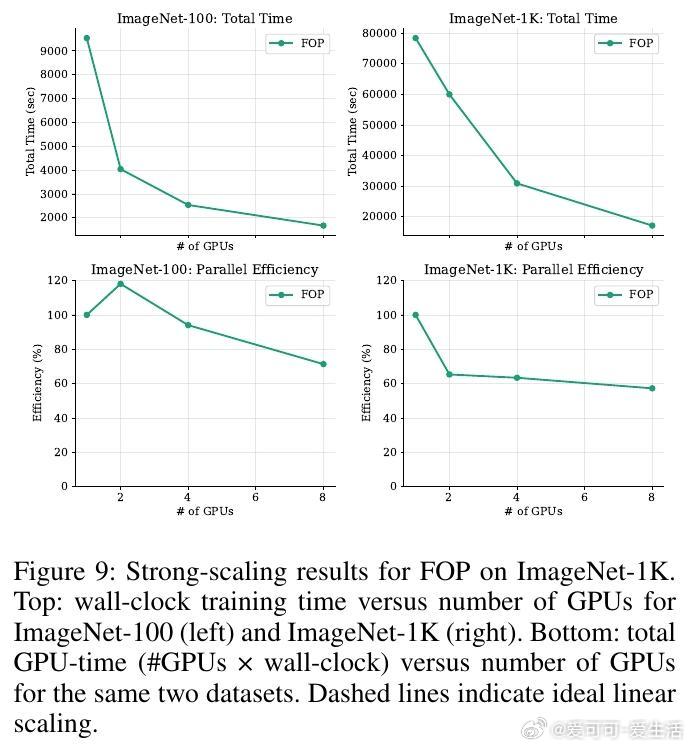

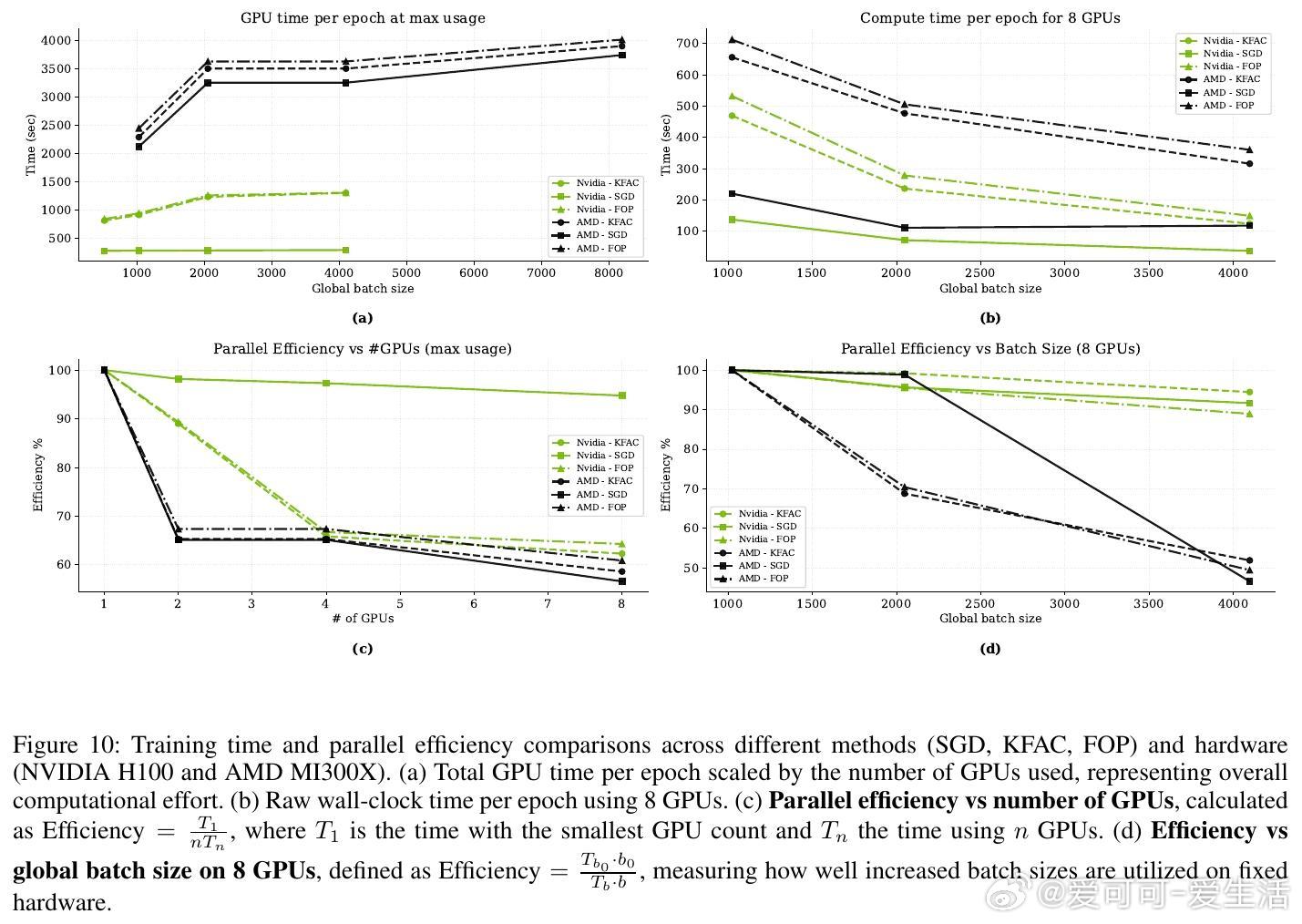

• 分布式实现支持多GPU数据与模型并行,通过双梯度AllReduce和广播机制高效同步,显著降低通信开销,适配现代数据中心环境。

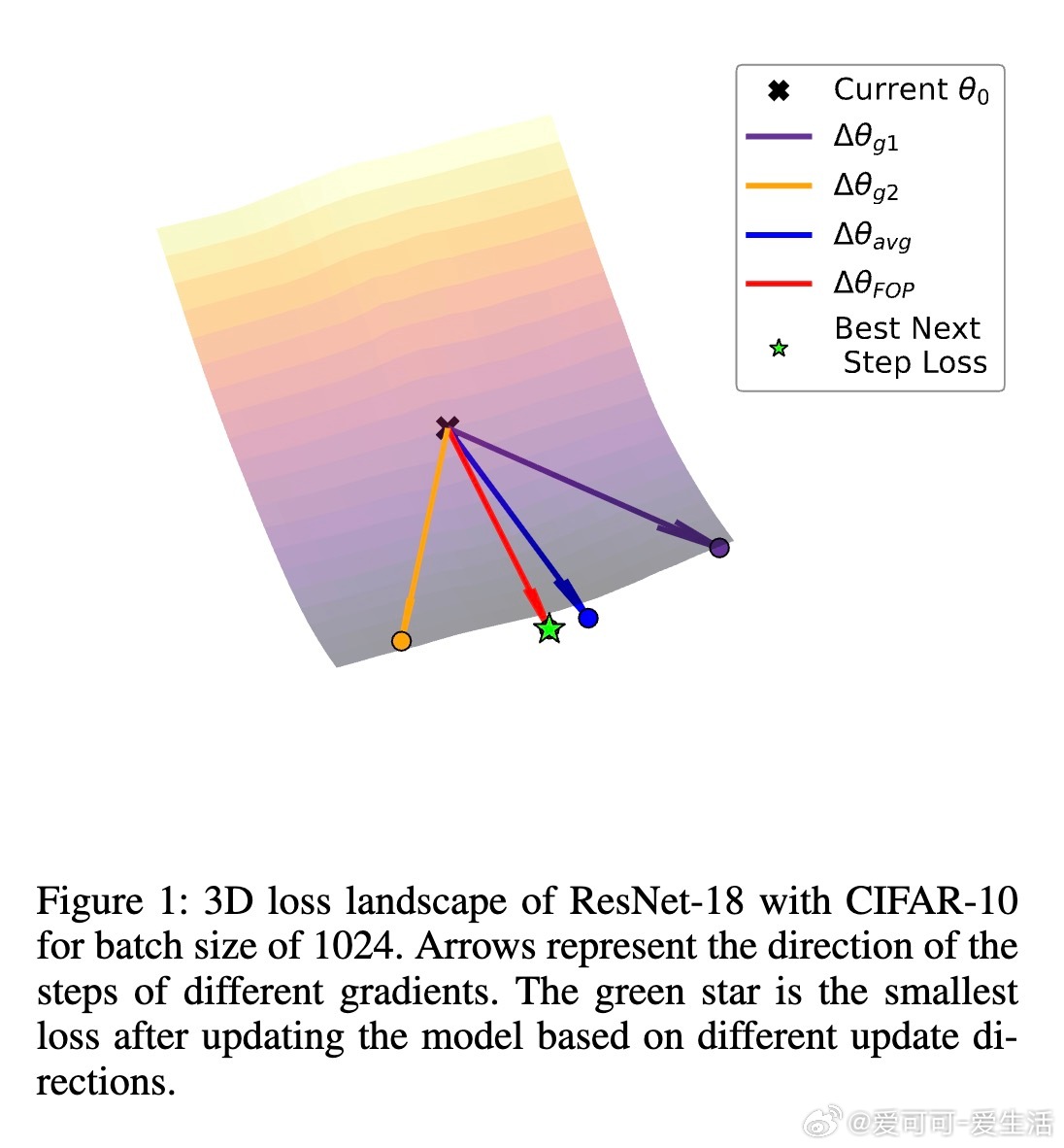

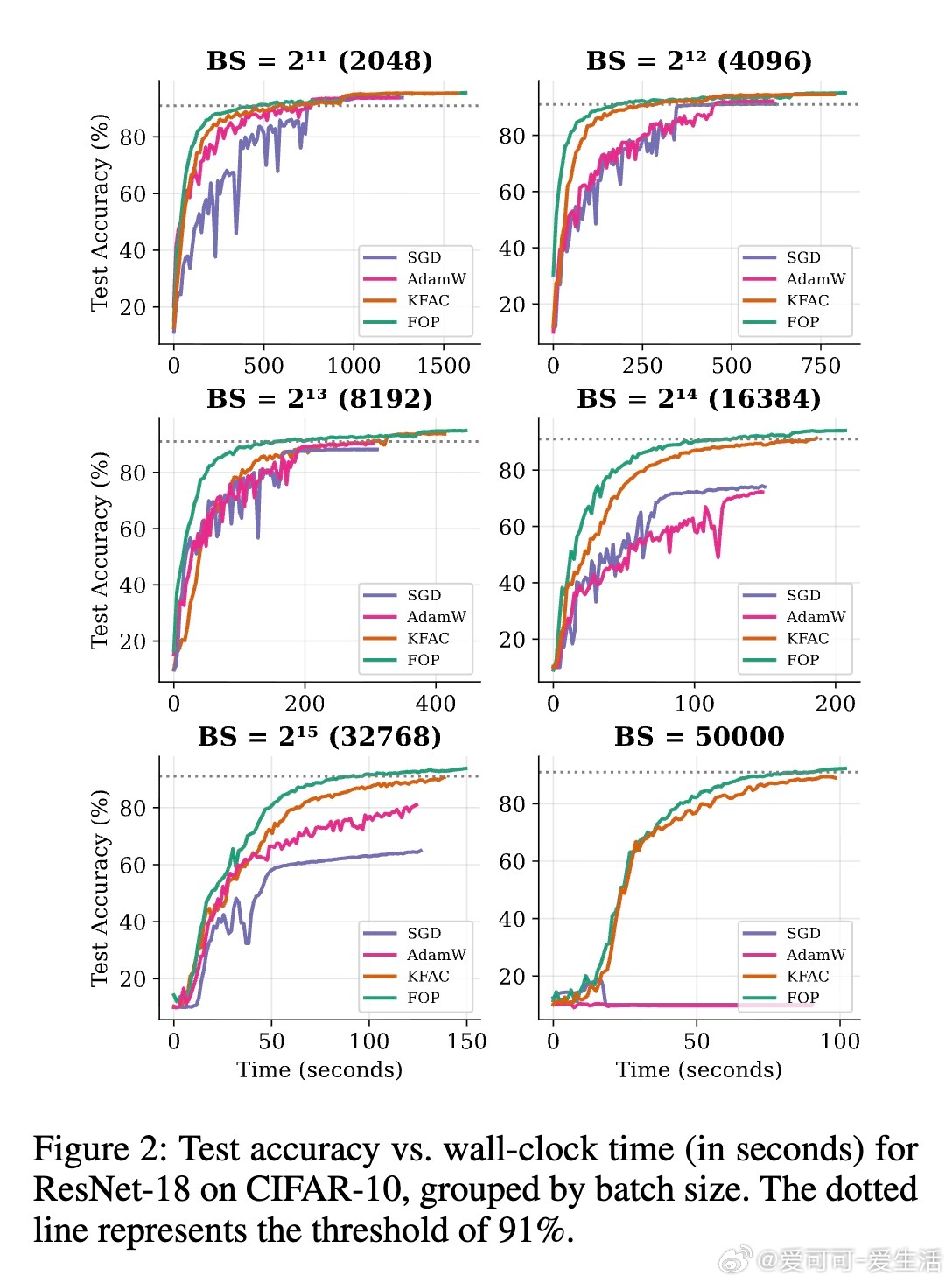

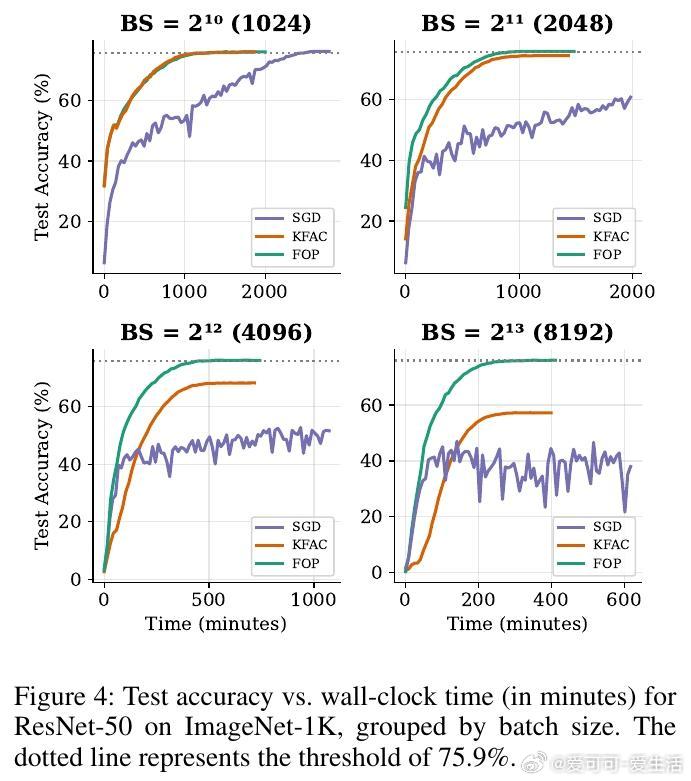

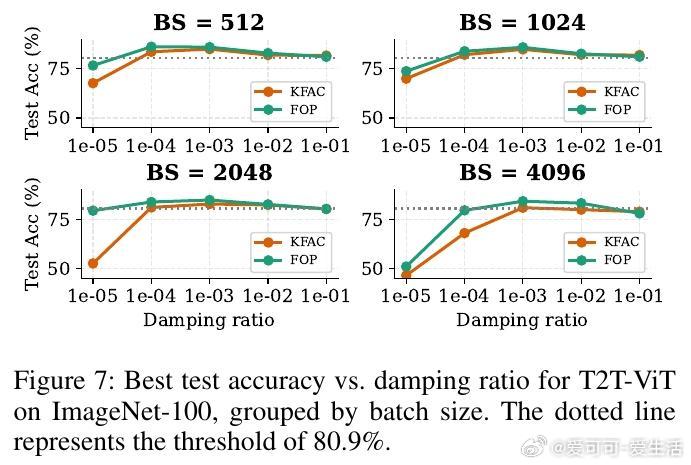

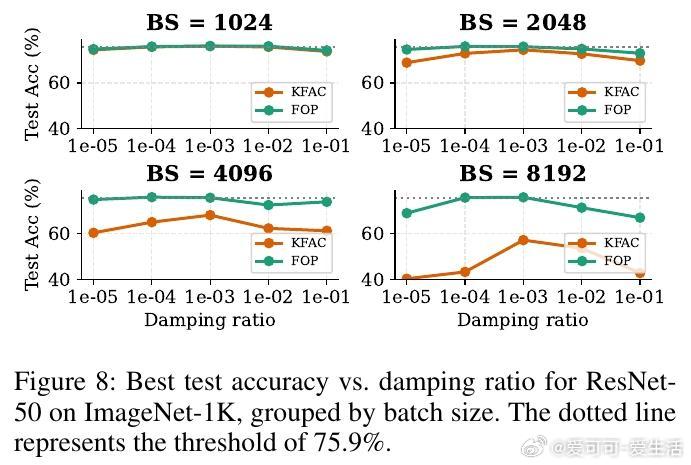

• 在CIFAR-10、ImageNet-100、ImageNet-1K及长尾CIFAR-LT等多种视觉任务上全面验证,较KFAC和一阶方法展现1.2–7.5倍加速,且在极大批次下保持甚至提升准确率。

• 特别在长尾不平衡数据集上,FOP降低Top-1错误率2.3–3.3%,表现出更强的泛化能力和鲁棒性。

• 具备更宽容的阻尼参数范围,减少超参数调优难度,且开源易集成,仅需一行代码即可替换现有优化器。

心得:

1. 利用Fisher正交投影捕获梯度间的几何正交信息,突破传统均值梯度的局限,为大批量二阶优化注入新活力。

2. 动态自适应的层级权重与步长机制有效协调主导与辅助梯度方向,提升收敛稳定性与效率,减少依赖经验调参。

3. 设计兼顾理论严谨与工程实践,分布式策略降低通信与计算瓶颈,充分发挥现代GPU硬件潜力,实现大规模训练的可扩展性。

详情🔗arxiv.org/abs/2508.13898

自然梯度下降大批量训练二阶优化深度学习分布式训练神经网络优化Fisher信息计算机视觉

![这种说法,都不知道该哭还是该笑[捂脸哭]](http://image.uczzd.cn/5551250165809116256.jpg?id=0)

![小说里的男女主们都开始读幼儿园了[笑着哭]](http://image.uczzd.cn/6080897835923629375.jpg?id=0)