[LG]《Latent learning: episodic memory complements parametric learning by enabling flexible reuse of experiences》A K Lampinen, M Engelcke, Y Li, A Chaudhry... [Google DeepMind] (2025)

机器学习系统普遍缺乏“潜伏学习”能力——即学习那些当前任务无关但未来任务可能有用的信息。本文提出,认知科学中的情景记忆机制能够弥补这一缺陷,提升模型的泛化能力。

• 潜伏学习定义为对非当前任务相关信息的隐含学习,这种信息在未来任务中可能至关重要,当前的参数化学习难以实现对这类信息的灵活复用。

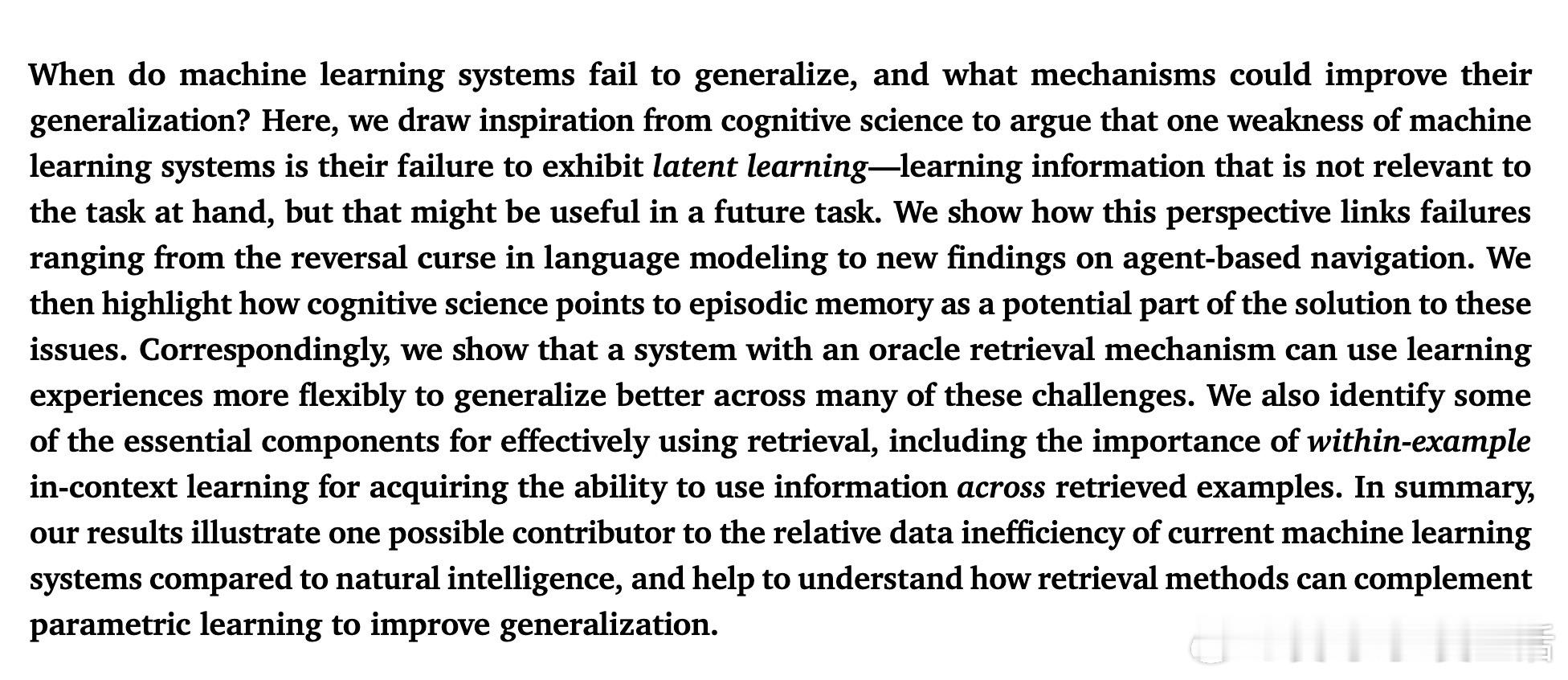

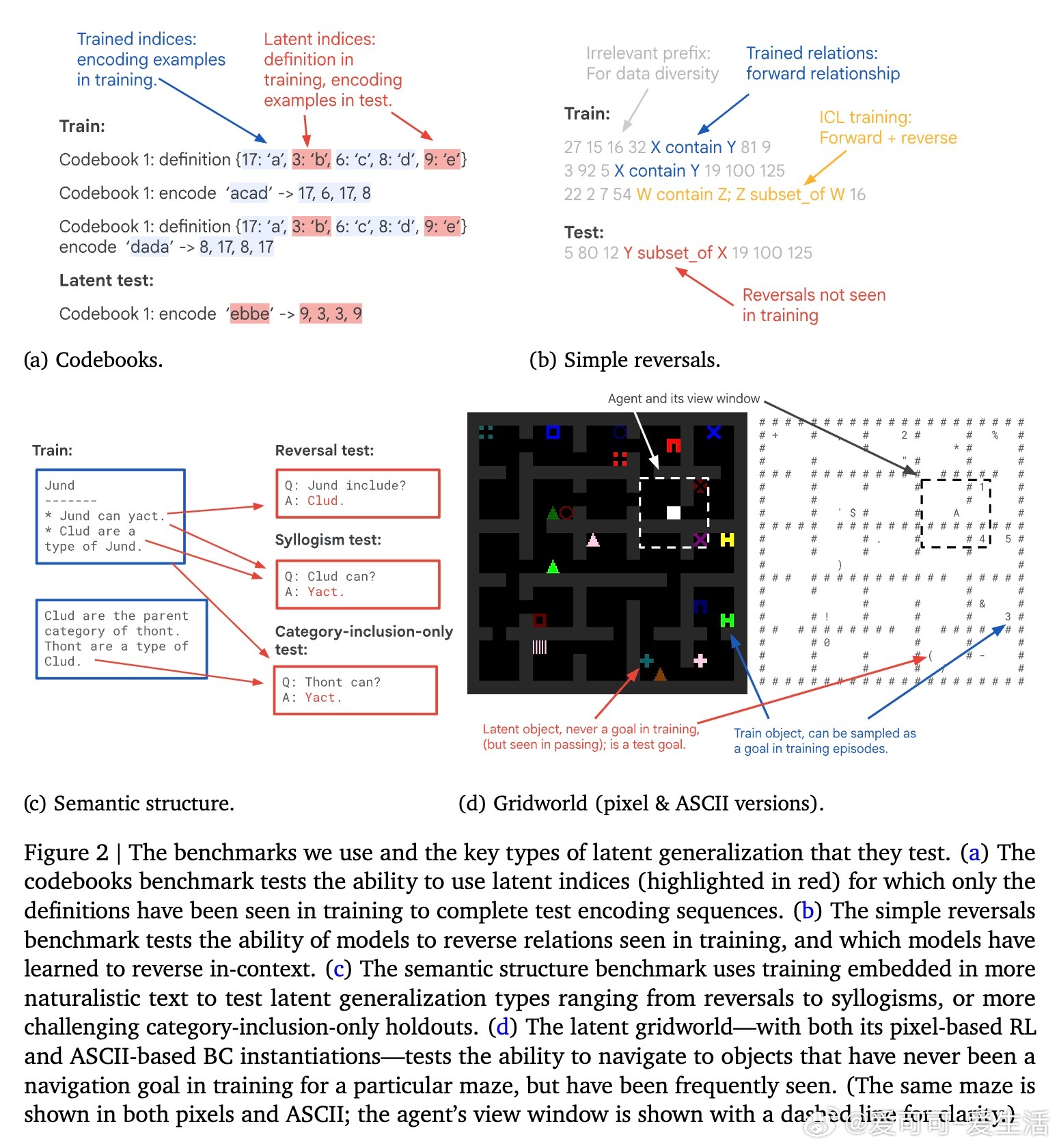

• 经典语言模型存在“反转诅咒”问题(reversal curse),即训练中学到的关系难以逆向推广,尽管模型在上下文中能完成逆向推理,显示潜伏信息确实存在但未被有效利用。

• 认知科学揭示,情景记忆(episodic memory)与参数学习互补,情景记忆快速存储具体经历,支持灵活检索并激活相关信息,促进跨任务泛化。

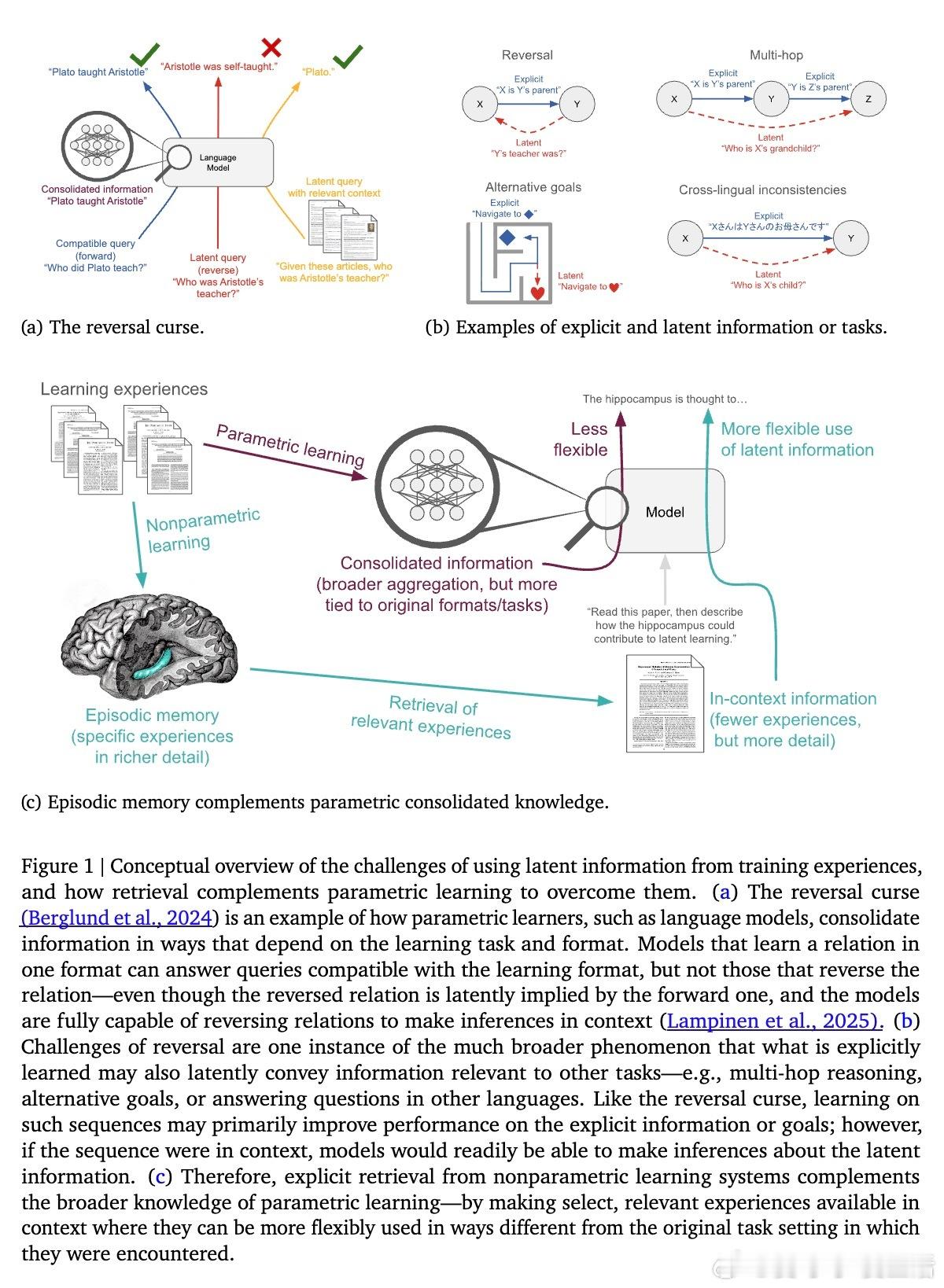

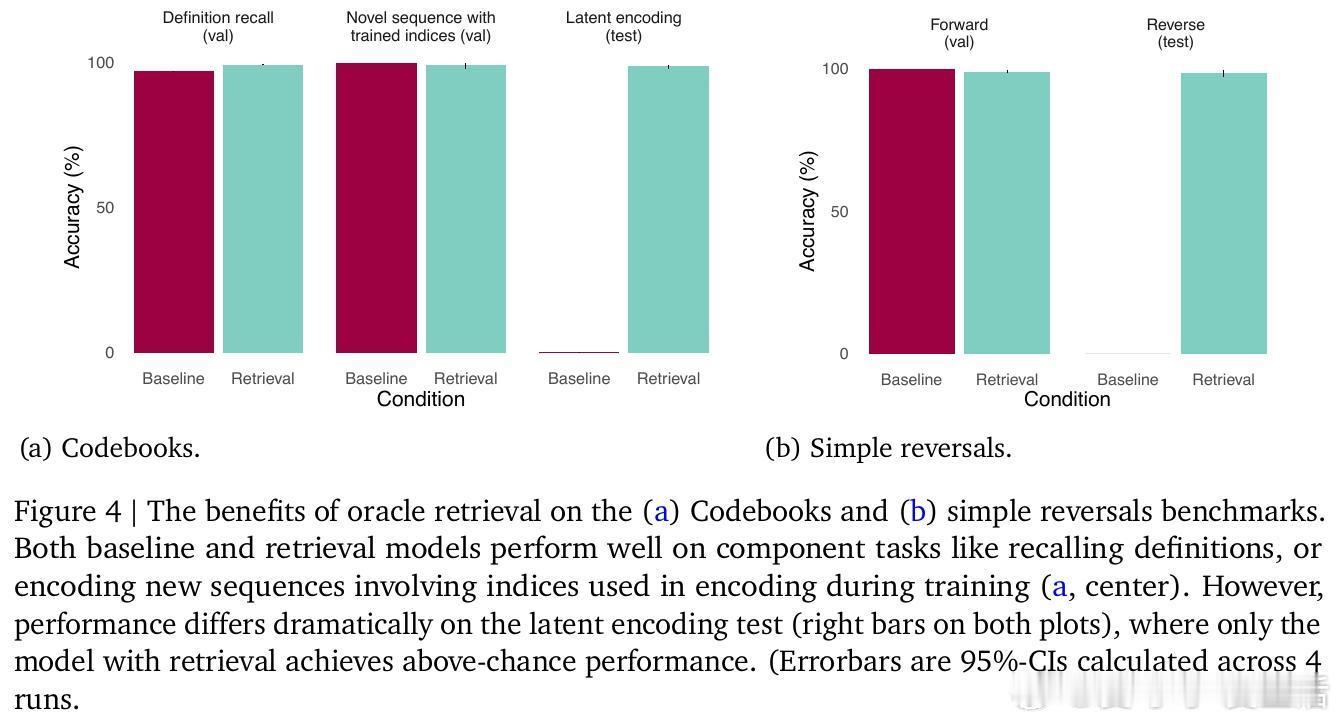

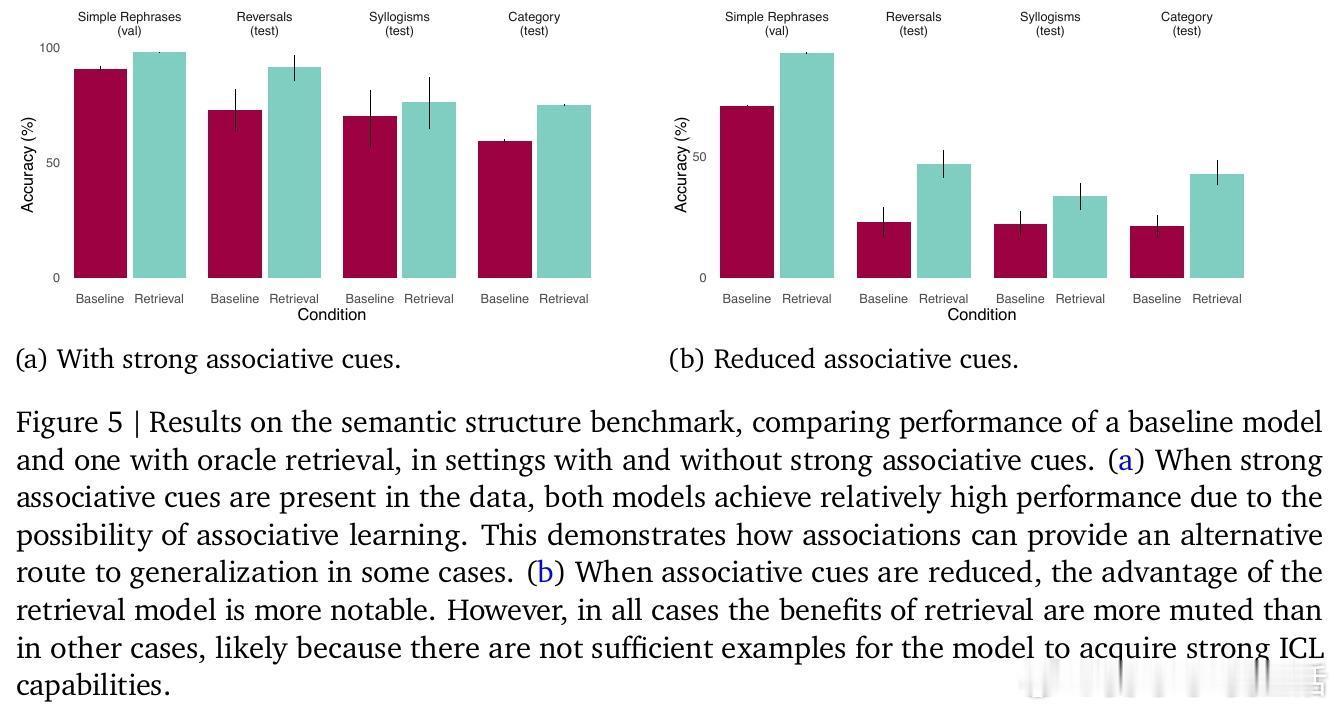

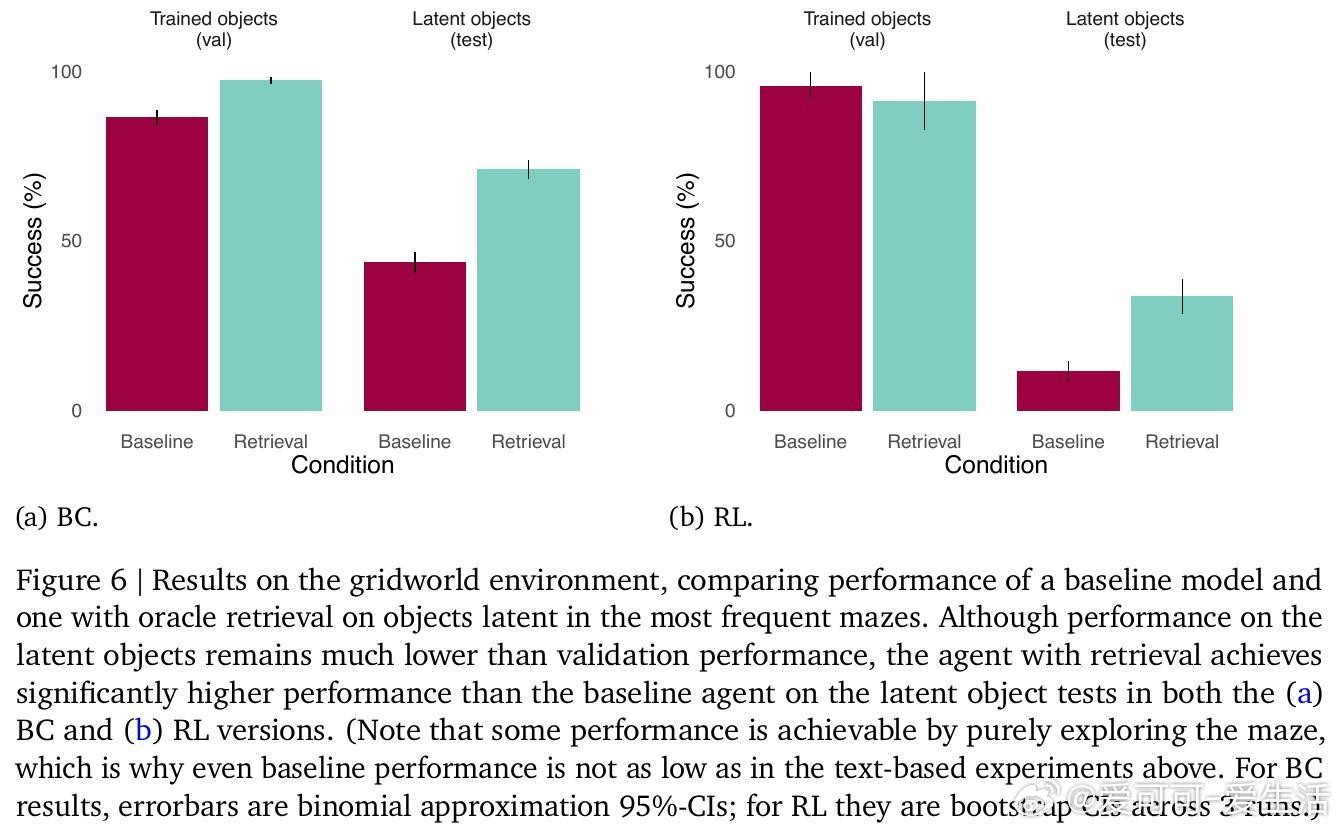

• 通过设计包括编码簿、简单反转、语义结构和潜伏网格世界导航等多样化基准,系统验证了基线Transformer模型在潜伏学习任务上的显著失败及情景记忆检索的有效性。

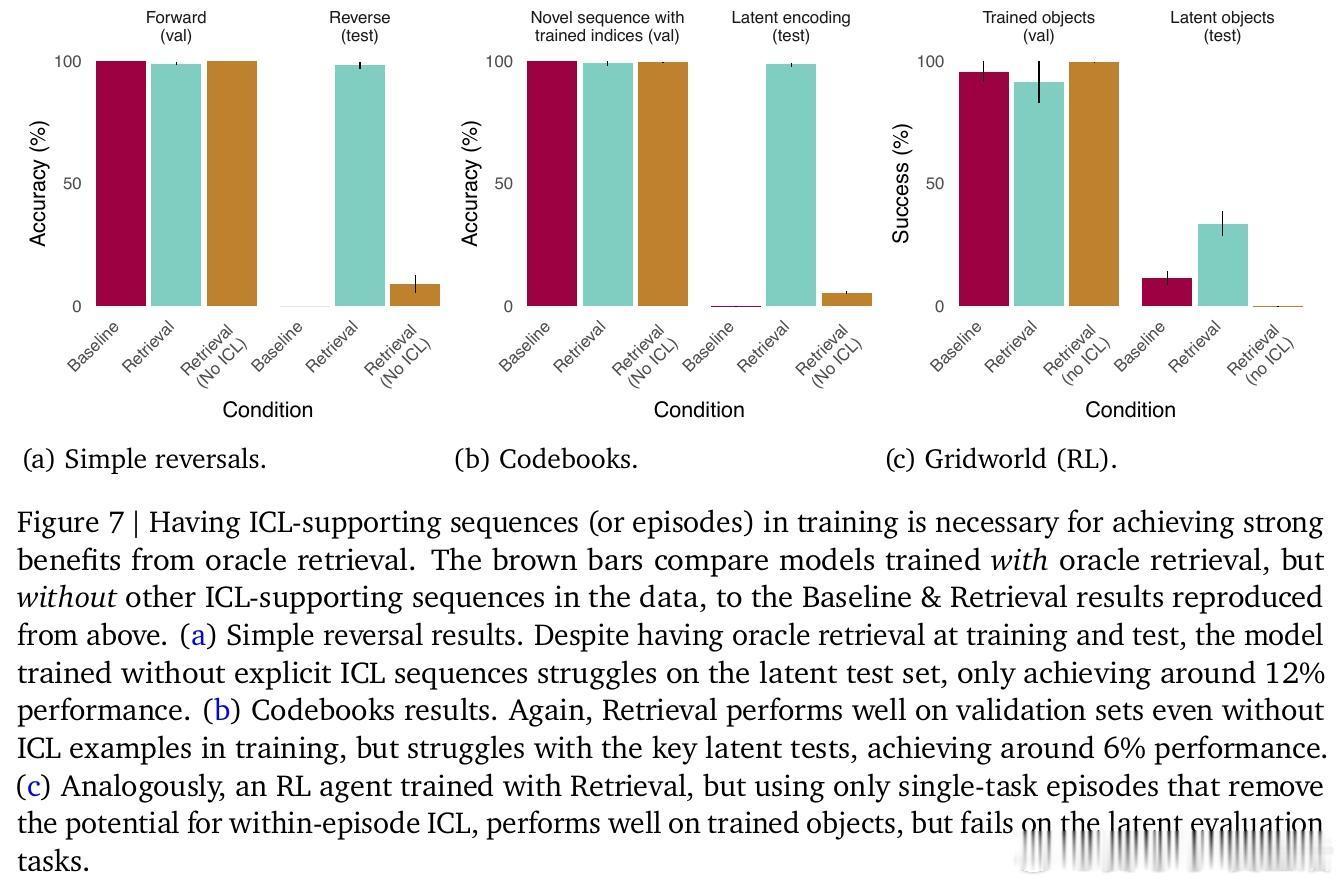

• Oracle检索机制显著提升模型在潜伏任务中的表现,尤其是在缺乏强关联线索或训练中缺少上下文学习示例时,强化了检索与上下文内学习(in-context learning)的协同作用。

• 强调训练中须包含促进上下文内学习的示例,帮助模型学会跨检索实例灵活使用记忆信息。

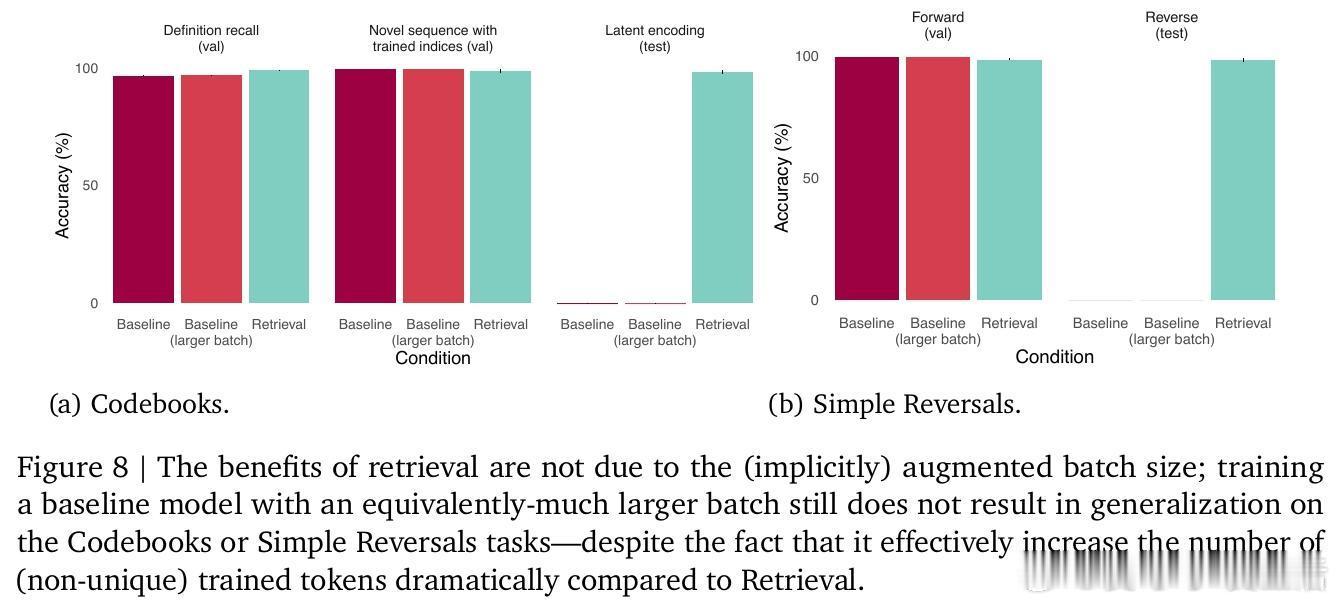

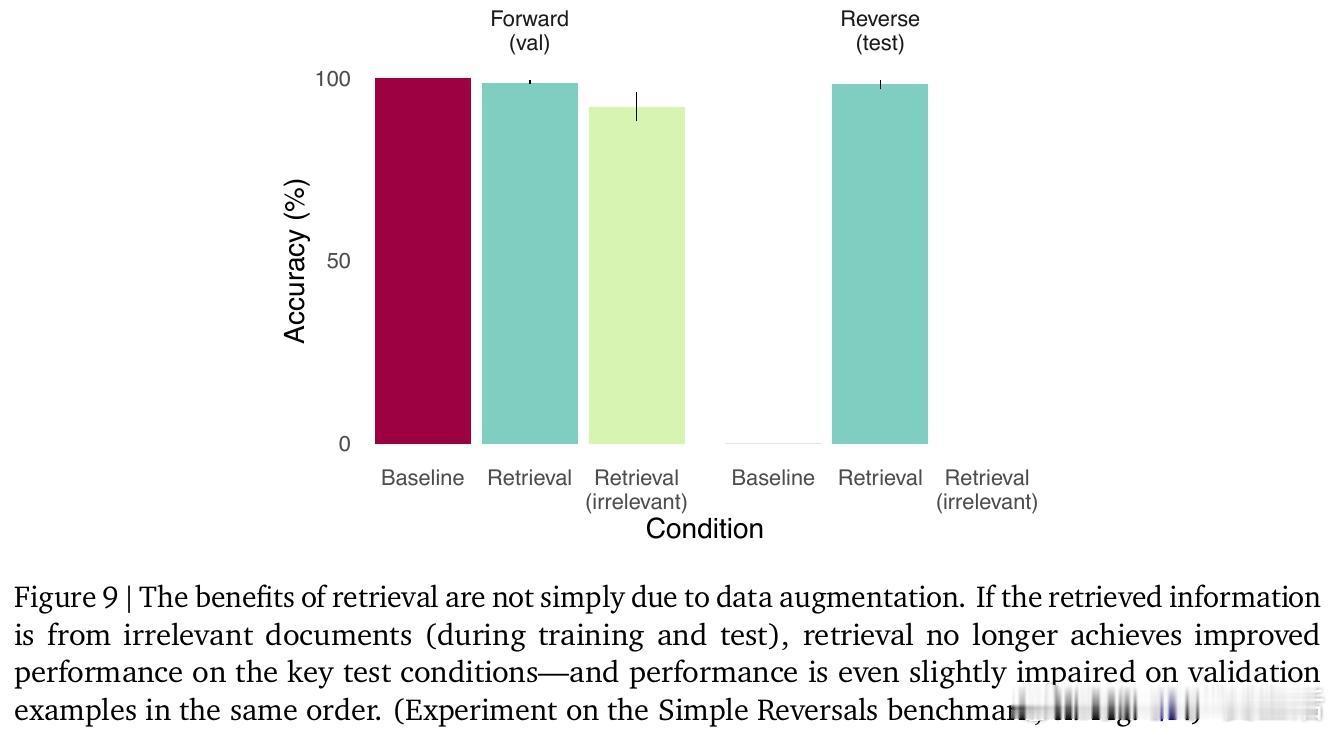

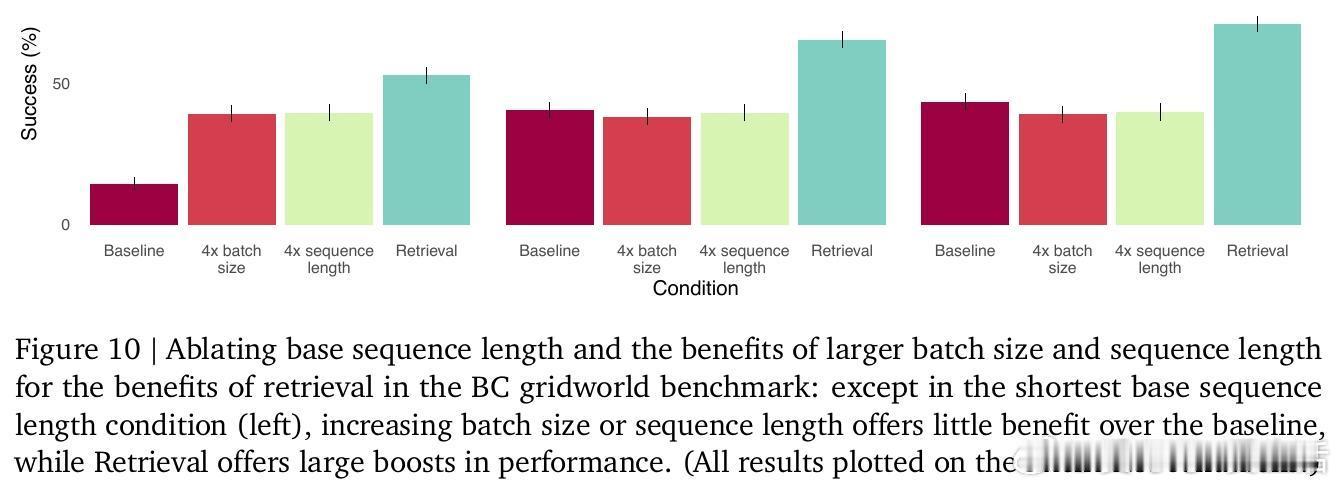

• 多项消融实验排除检索优势源于批量大小增加或数据增强,验证检索机制本身对潜伏学习的独特贡献。

• 认知科学的互补学习系统理论(complementary learning systems)为AI设计提供启示:结合参数化模型与情景记忆检索,模拟海马体作为记忆索引的角色,有望提升机器智能的灵活性和泛化能力。

• 潜伏学习的突破不仅能缓解当前机器学习数据效率低的问题,还为理解和实现更接近人类智能的系统指明方向。

心得:

1. 泛化失败不只是模型容量或训练数据不足,关键在于模型缺乏对潜伏信息的灵活访问和复用能力。

2. 训练时单纯优化显式任务目标无法培养出泛化到隐含任务的能力,检索机制为此提供了更灵活的路径。

3. 未来AI需融合多种泛化策略,情景记忆检索与训练时任务扩充互为补充,共同提升系统适应复杂多变环境的能力。

更多详情🔗 arxiv.org/abs/2509.16189

人工智能机器学习认知科学泛化能力情景记忆检索增强模型