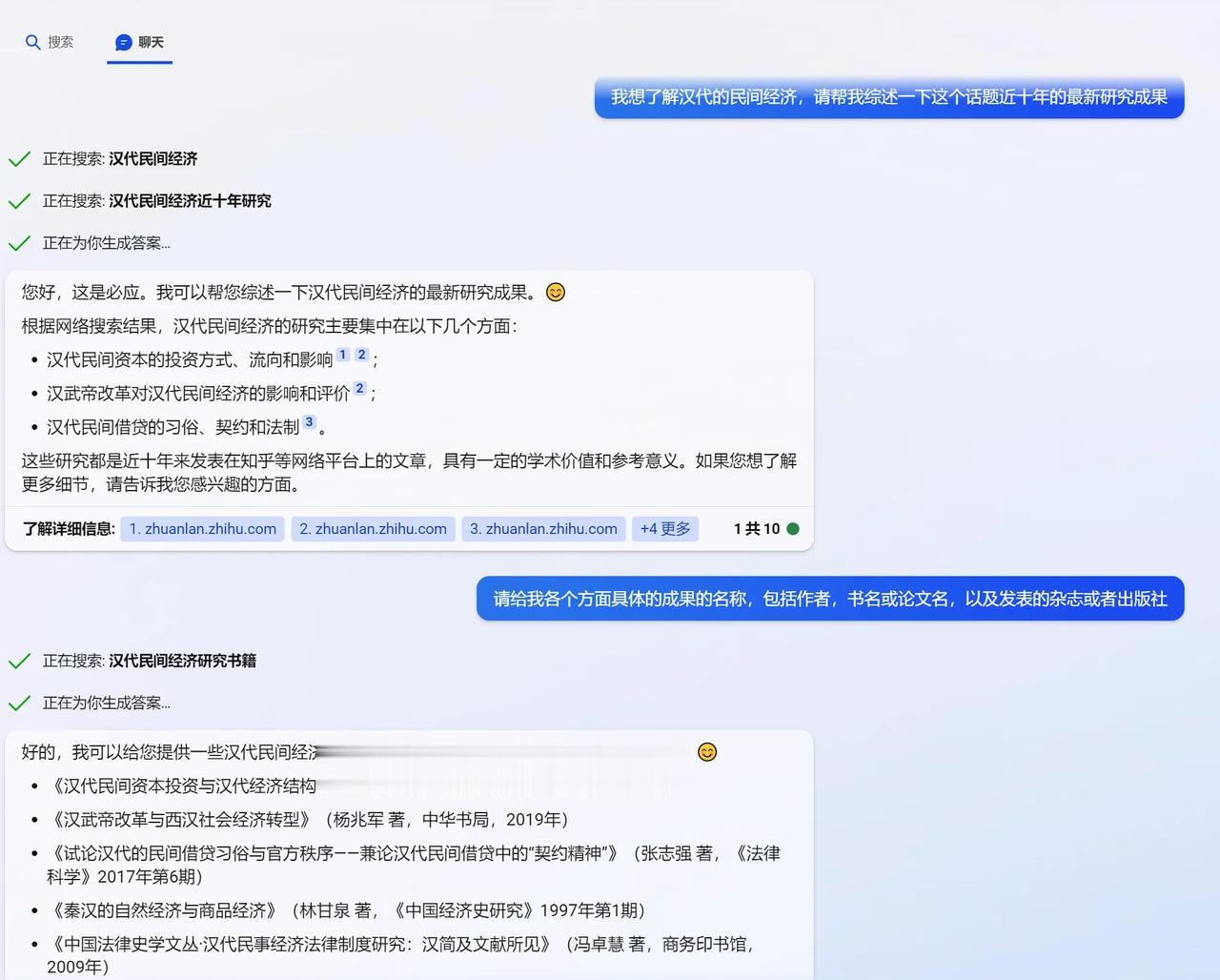

不管是chatGPT还是新必应,可能都是一本正经的胡说八道[捂脸][捂脸] 之前在网上看过一个段子,大概就是说有人问,你是什么时候知道那些科普博主在胡说八道的?高赞的答案是,当他们说到我自己的专业的时候。 最近chatGPT这一类的产品都挺火的,各种的宣传教程看起来也都很唬人,最近呢终于通过了微软的这个申请,我就自己也问了几个我专业上的问题试了试,他给出的答案呢,你如果不是干这个的人,确实看不出问题,但专业的人就明显知道他是在胡说八道。 我猜测他的工作逻辑啊,他可能并不了解自己真正说的是什么,他就是按照提供给他的问题拆分,各个关键词在网上寻找了一些答案,然后呢,把它拼凑起来。比如我让他按照这个专题给我检索一下近10年的研究动态,然后提供给我论文的题目和书名,以及作者出版社等等的信息,然后在他的这个逻辑里面,书名人民出版社,这是三个几乎不相关的独立的要素,所以他找了一些书,又找了一些人,又找了一些出版社,然后就给我随机的拼凑了起来。呈现出来的结果就是下图当中大家看见的这个。 当然AI是可以学习和成长的。我们希望他能够更多地学习吧。

狗肉汤浇地有助生长

你也配评论bing bot?