[LG]《Recurrence-Complete Frame-based Action Models》M Keiblinger [Prime Intellect] (2025)

挑战“Attention已足够”论断,突破长时序任务瓶颈!

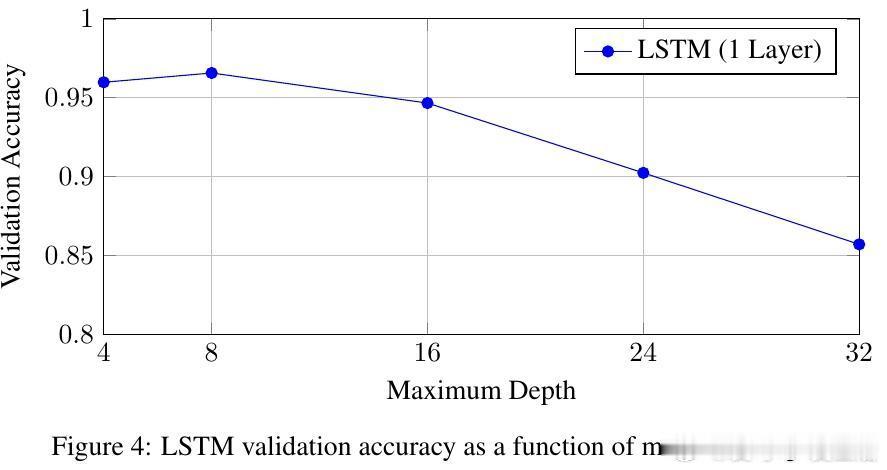

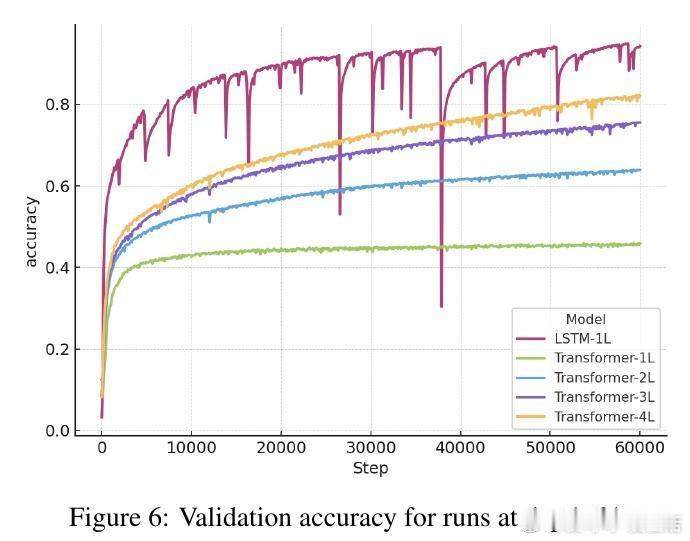

近期,注意力机制在大语言模型中大放异彩,甚至有观点宣称RNN不再必要。然而,作者Michael Keiblinger指出,完全可并行的模型无法准确捕捉某些长期运行的智能体任务中的关键问题。论文提出一个“临界时间t”概念,揭示非递归完整模型在超过该时间后,无法正确整合输入信息,尤其对软件工程等代理系统影响深远。

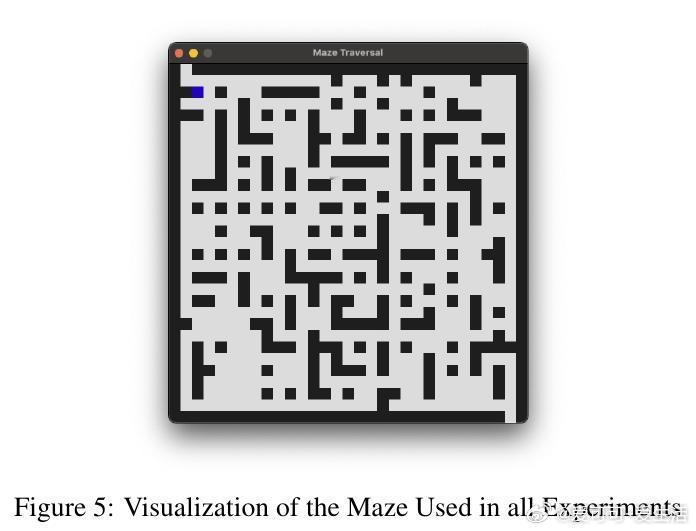

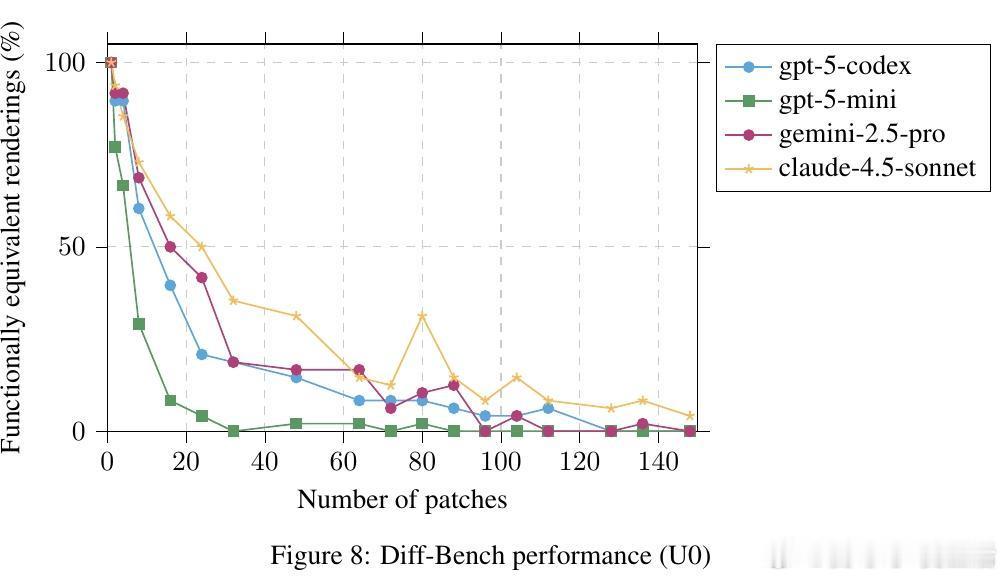

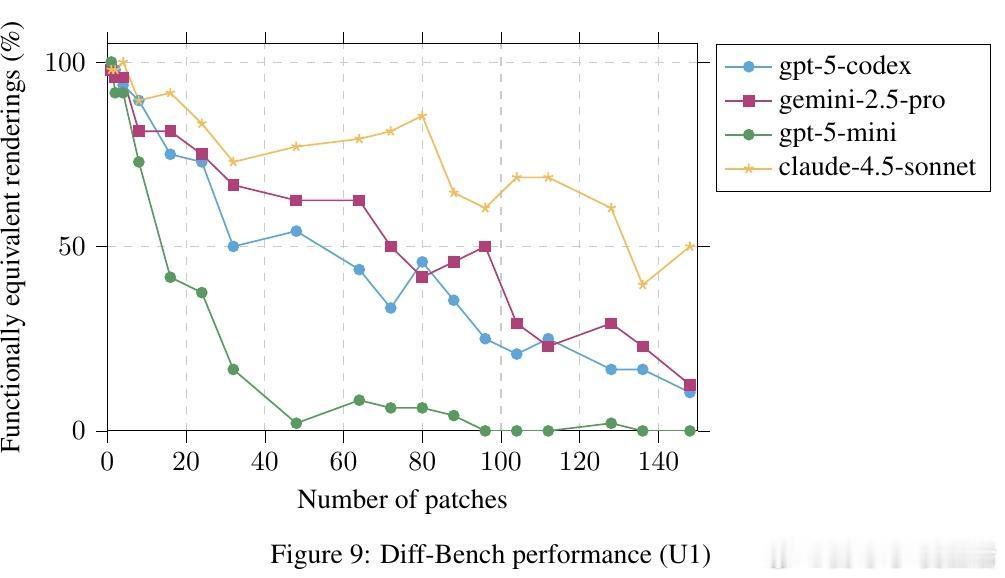

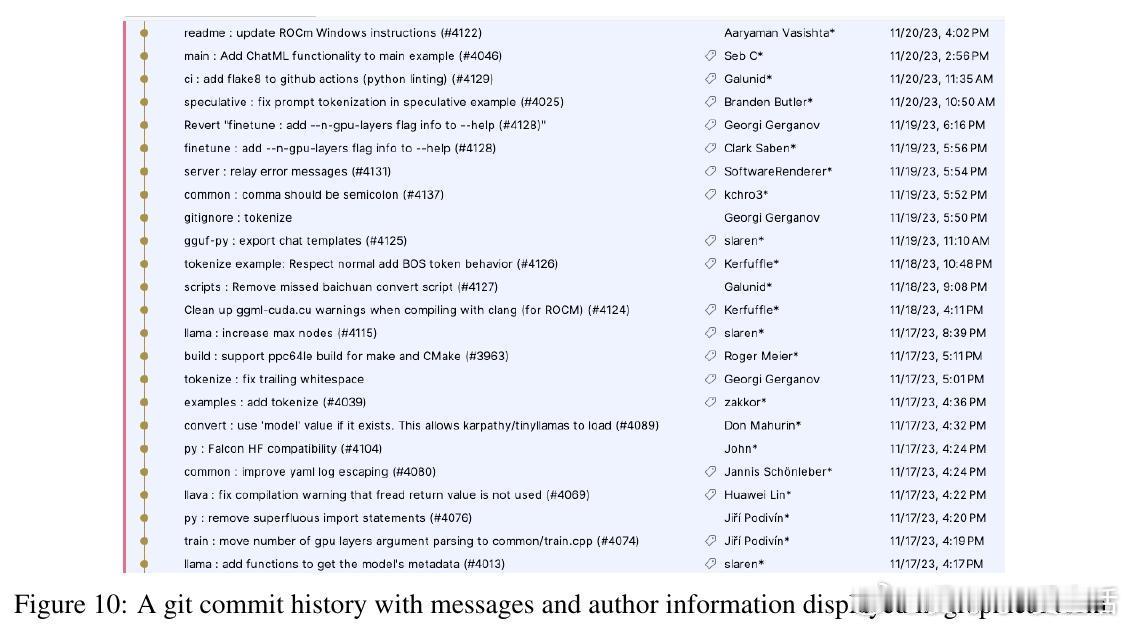

为此,作者设计了一种递归完整架构(Recurrence-Complete Architecture),并在GitHub派生的动作序列上训练。实验结果显示:训练损失随着序列长度呈幂律下降,且参数量保持不变;更长序列训练虽然线性增加计算时间,但从整体时间角度看,却带来更低的损失,效率更优。

这不仅重新点燃了递归机制在序列建模中的价值,也为构建更可靠、更持久的智能代理系统提供了理论和实践支持。

🔗论文链接:arxiv.org/abs/2510.06828

机器学习 人工智能 递归神经网络 注意力机制 长序列建模 智能代理