216页强化学习综述谷歌DeepMind强化学习综述

216页强化学习(RL)综述来了,作者是谷歌DeepMind研究员Kevin P. Murphy。

这份综述从经典的Q-learning一路讲到大语言模型(LLM)与通用人工智能(AGI),几乎涵盖了RL的过去、现在与未来,是一篇兼具深度与广度的优质参考资料。

一、什么是强化学习:

强化学习研究的是顺序决策问题。智能体(Agent)在与环境交互中,通过不断选择动作、接收奖励、更新策略,目标是实现长期回报最大化。常见的建模框架包括:

- 马尔可夫决策过程(MDP)

- 部分可观测马尔可夫决策过程(POMDP)

- 上下文赌博机(Contextual Bandits)

换句话说,强化学习让机器在试错中不断成长。

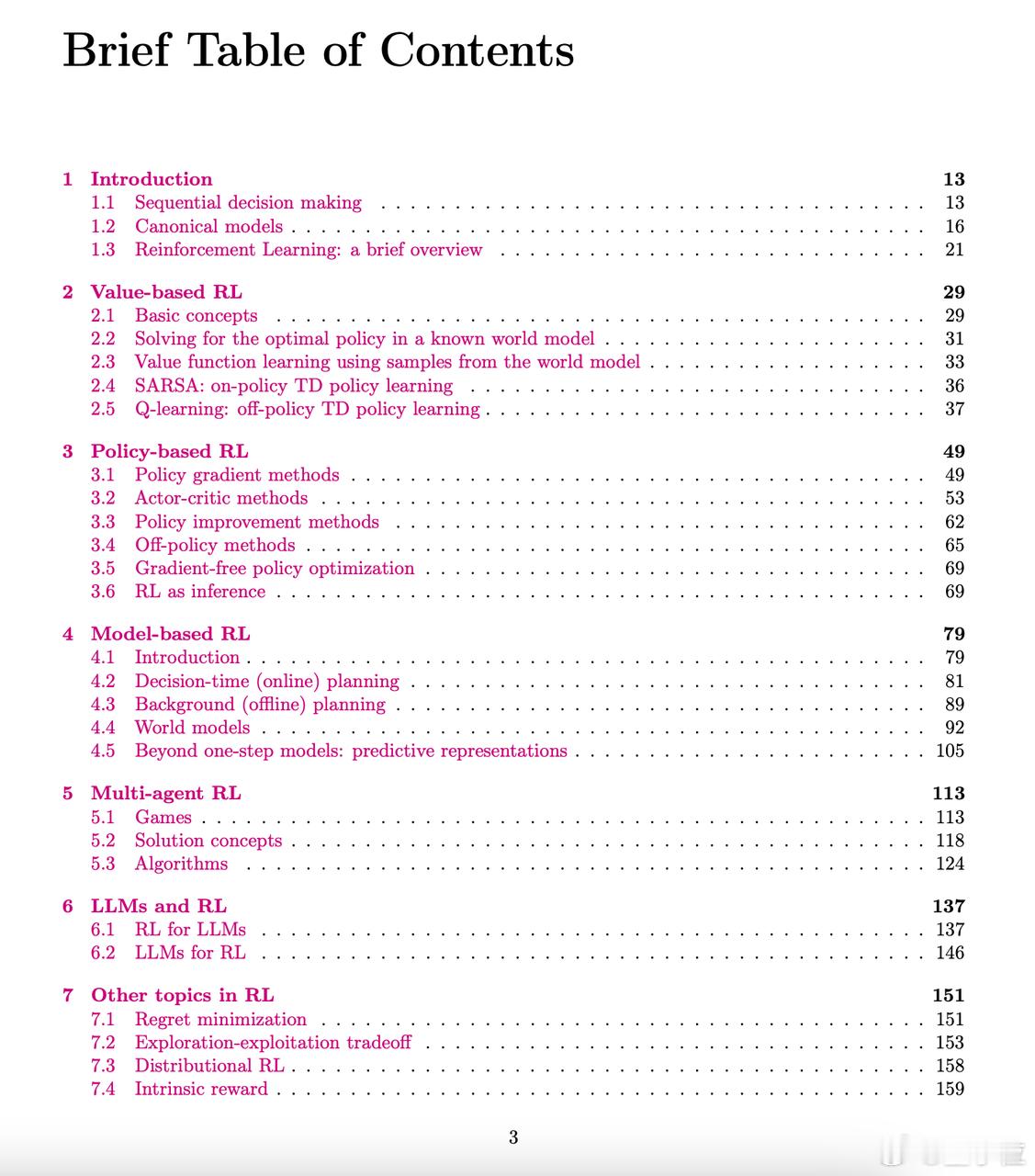

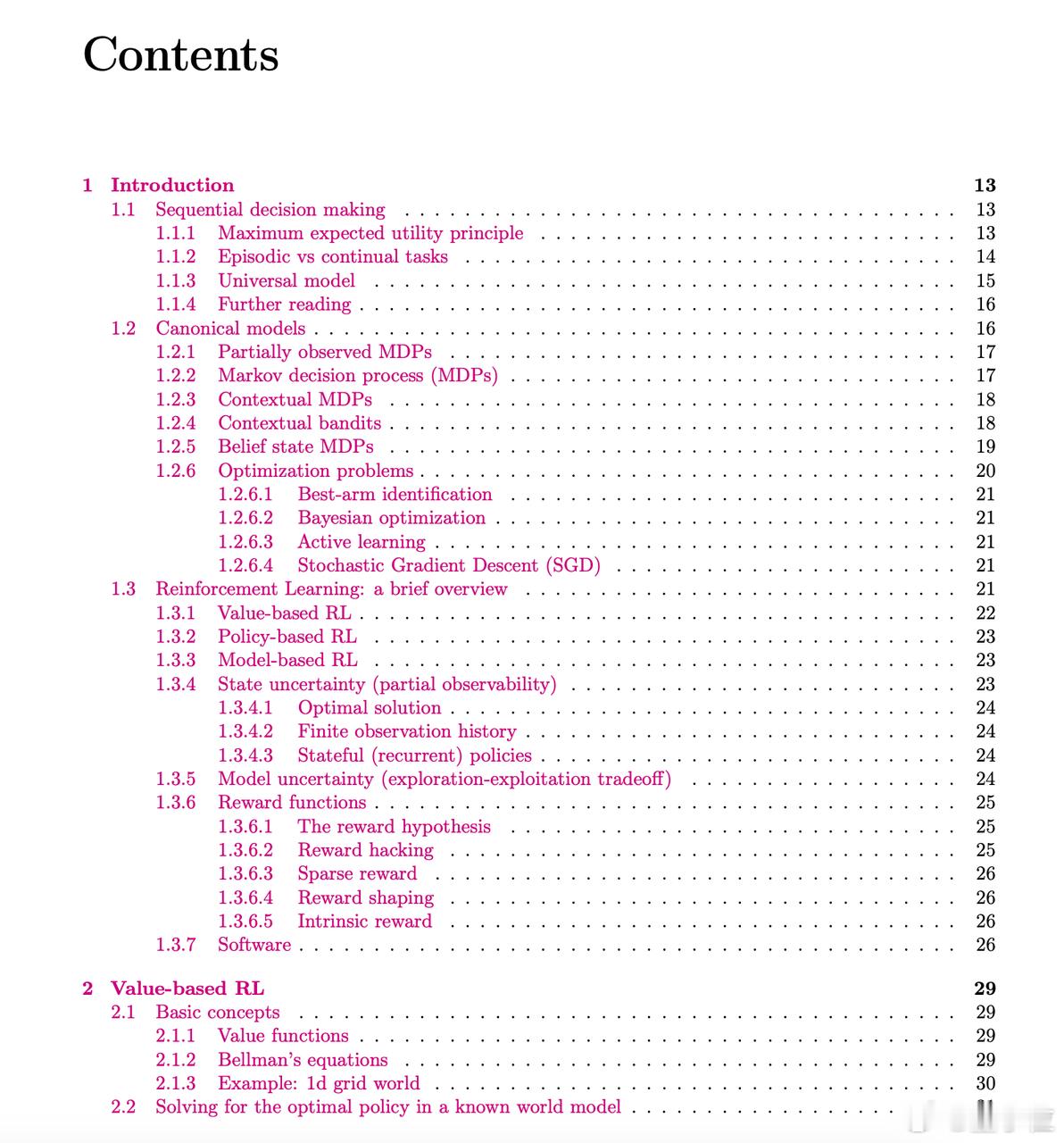

二、三大主流方法流派:

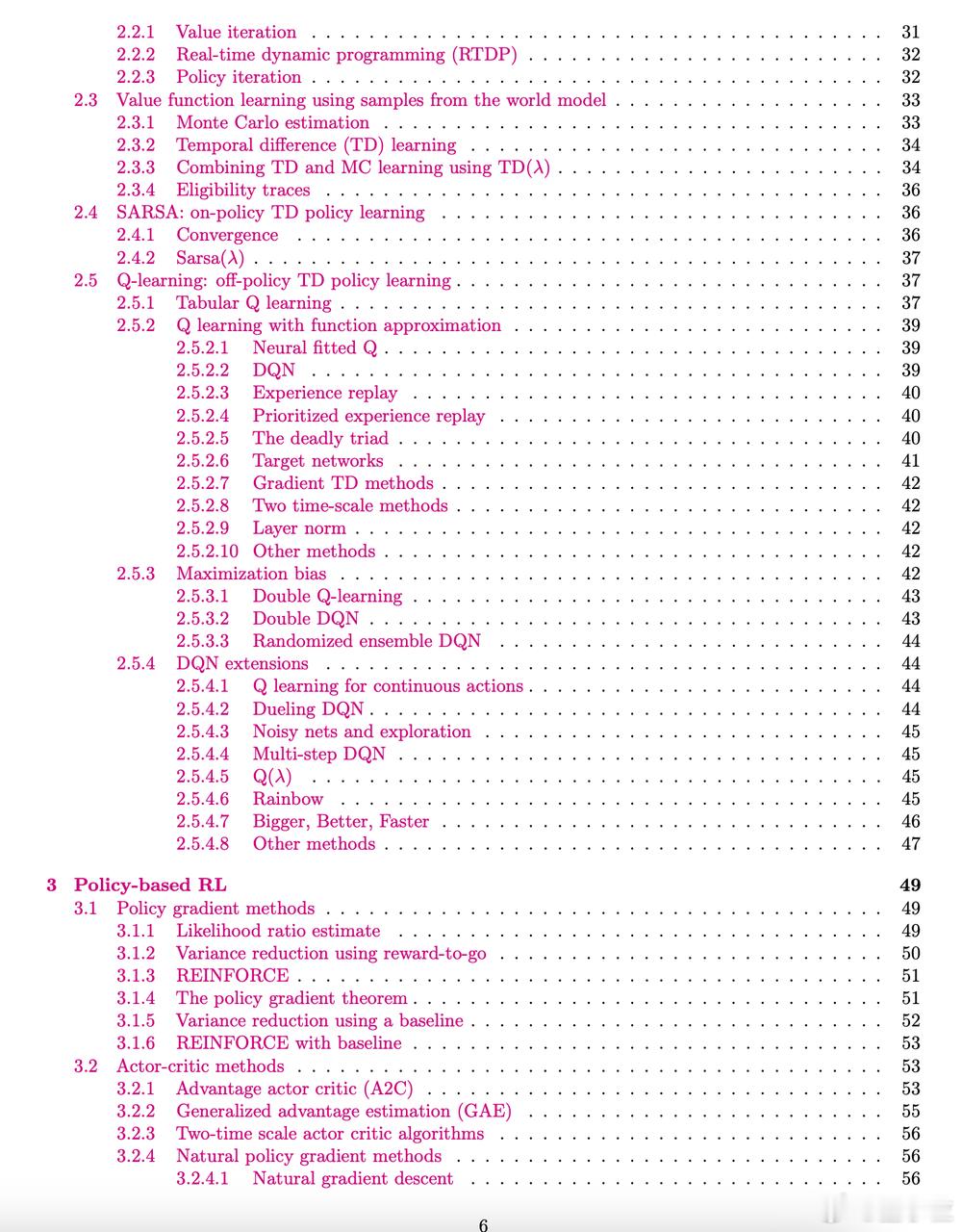

1. 值函数方法:如Q-learning、DQN。估计某状态下某动作的价值,然后选择最优动作。

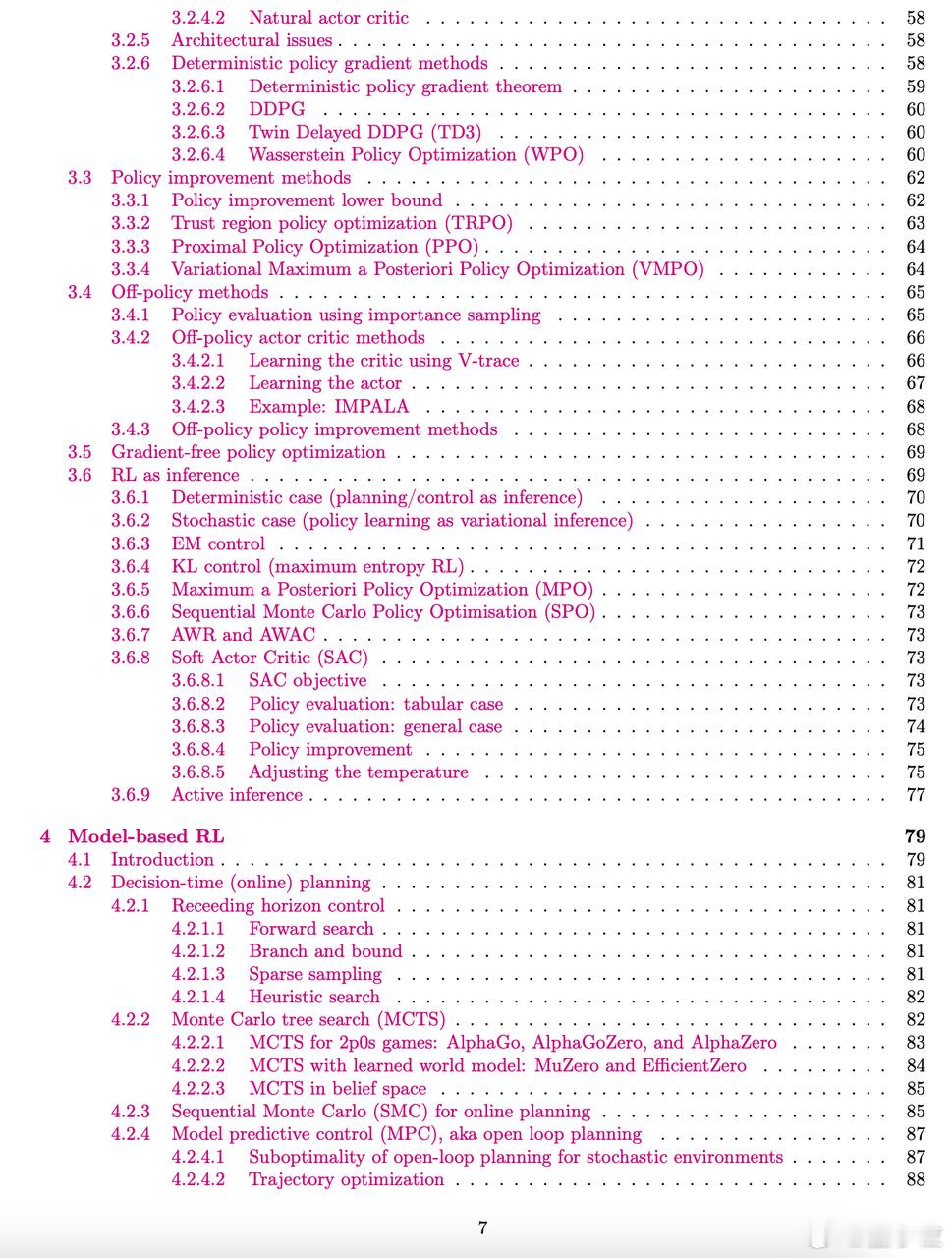

2. 策略方法:如PPO、SAC。直接优化动作的概率分布,让高回报动作更易被执行。

3. 模型方法:如MuZero、Dreamer。学习环境的动态模型,赋予智能体“想象力”,提升学习效率。

三、两种学习范式:

- On-policy:使用智能体当前策略生成的数据进行学习(如SARSA)。

- Off-policy:利用其他策略生成的历史经验进行学习(如Q-learning、DQN)。

四、关键机制与训练技巧:

- Actor-Critic架构:Actor负责决策动作,Critic评估动作价值。

- 探索与利用的平衡:既要执行已知最优动作,也要尝试新动作。常见方法有ε-greedy、UCB、Thompson Sampling。

- 提升训练稳定性的技巧:如经验回放、目标网络、Double Q-learning、Rainbow等。

五、更前沿的研究方向:

1. 多智能体强化学习(Multi-agent RL):研究多个智能体间的合作与对抗,融合博弈论思想。代表案例有AlphaStar(星际争霸)、Cicero(外交官)。

2. RL与LLM的融合:

- RL用于LLM对齐:包括[RLHF](Reinforcement Learning with Human Feedback)、[RLAIF](Reinforcement Learning with AI Feedback)、GRPO、DPO等方法。

- LLM增强RL能力:LLM可用来构建奖励模型、世界模型,甚至生成策略代码。

3. 层级强化学习(Hierarchical RL):将复杂任务拆分为多个子目标,提升学习效率。常见方法有HER、Options等。

4. 模仿学习:智能体模仿人类示范行为,包括行为克隆与逆强化学习(IRL)。

5. 离线强化学习(Offline RL):无需环境交互,仅依赖历史数据进行策略学习,适用于高成本或高风险场景。

六、未来发展方向:

作者在文章结尾指出,强化学习正逐步演化为一个统一的智能系统框架,正在与概率推断、控制理论及大模型技术融合,有望成为实现类人智能(AGI)的关键路径。

这份216页的综述既适合新手快速建立整体认知,也能帮助研究者系统梳理技术脉络,感兴趣的小伙伴转发起来吧。

原文链接:arxiv.org/abs/2412.05265